Notizie AI Gennaio 2026: Novità dell'ultima settimana (19-25 Gennaio)

Quanto puoi fidarti di un LLM che include pubblicità?

La settimana dal 19 al 25 Gennaio 2025 ha portato aggiornamenti sia sul fronte della ricerca che su quello dei prodotti consumer. Dai nuovi paradigmi di efficiency proposti da Liquid AI alle pubblcità su ChatGPT, per concludere con l'Universal subspace hypothesis. Di seguito un resoconto delle principali notizie settimanali.

Architetture emergenti e LLM: Liquid FM e TranslateGemma

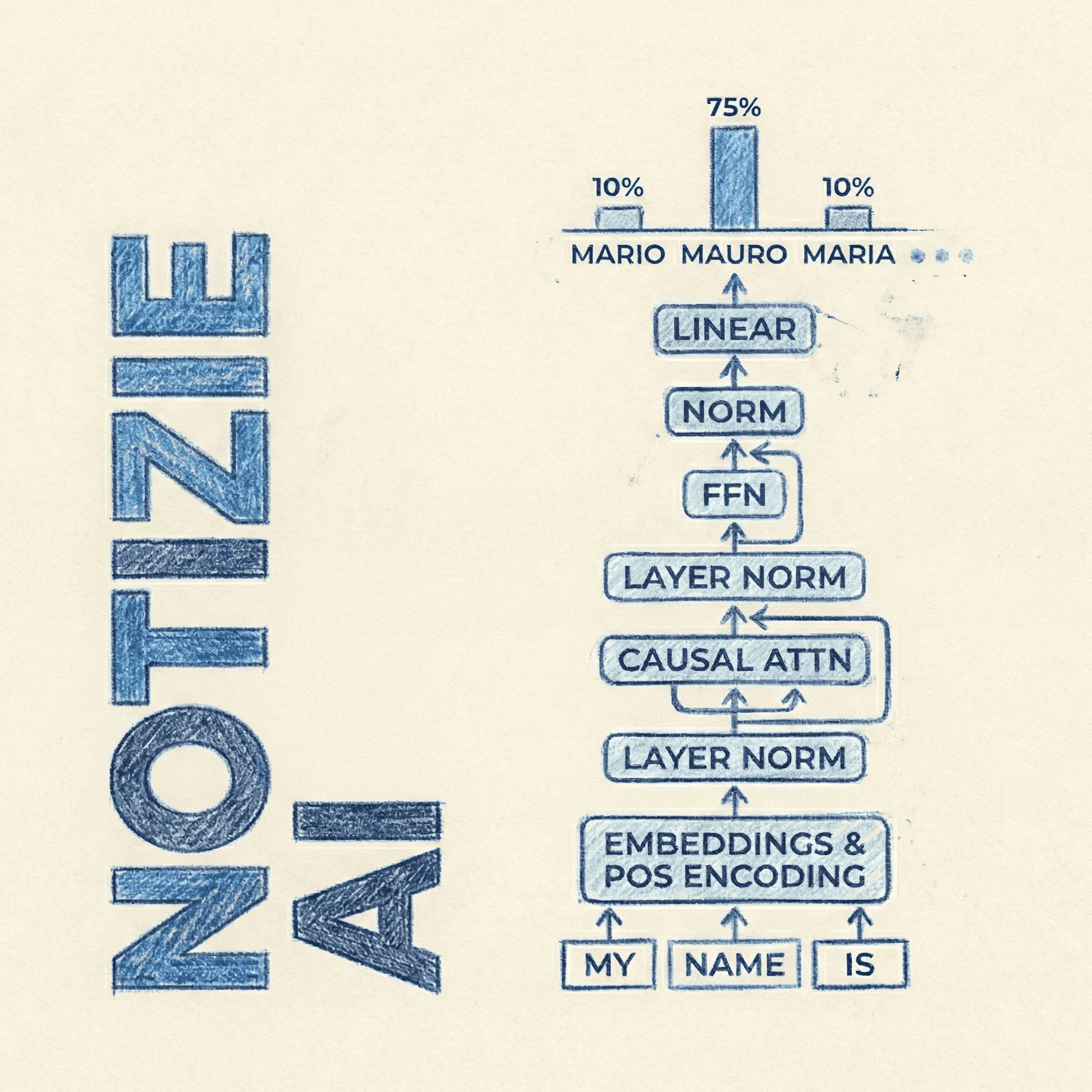

Il panorama dei Large Language Models continua a frammentarsi tra modelli generalisti massivi e soluzioni specializzate ad alta efficienza.

Liquid LFM-2.5-1.2B-Thinking

Liquid AI ha rilasciato una nuova iterazione dei suoi modelli basati su Liquid Neural Networks. Il modello LFM-2.5-1.2B-Thinking rappresenta un tentativo di integrare capacità di reasoning (Process of Thought) in un modello estremamente compatto (1.2 miliardi di parametri). A differenza dei classici Transformer che scalano quadraticamente con la lunghezza del contesto, questa architettura mira a mantenere un throughput elevato e un'impronta di memoria ridotta grazie a layer CNN disposti strategicamente nell'architettura.

La novità principale risiede nell'ottimizzazione del processo di inferenza per task che richiedono step logici intermedi, rendendo il modello competitivo con architetture dense molto più grandi. Per i dettagli sull'architettura e i benchmark, è disponibile l'analisi su Liquid LFM-2.5-1.2B-Thinking: Novità e Guida completa.

TranslateGemma

Google DeepMind ha introdotto TranslateGemma, una suite di modelli aperti ottimizzati specificamente per task di traduzione. Basati sull'architettura Gemma, questi modelli sono stati sottoposti a fine-tuning su dataset multilingua massivi per ridurre le "hallucinations" tipiche dei modelli generalisti quando operano su lingue a basse risorse.

Il rilascio evidenzia un focus sulla qualità del token alignment tra lingue diverse e sull'efficienza del decoding. Per approfondire le metriche BLEU e l'implementazione, consultare l'articolo TranslateGemma: Guida completa del nuovo modello open per la traduzione AI.

ChatGPT: Nuove strategie di Tiering e Ads

Dopo innumerevoli anticipazioni, l'introduzione della pubblicità nel tier Free di ChatGPT segna un cambiamento nel modello di revenue, mirando a sostenere i costi di inferenza dell'utenza non pagante. Parallelamente, è stato lanciato il piano ChatGPT Go al prezzo di 8€/mese. Questo tier intermedio offre accesso prioritario e context window estese rispetto alla versione gratuita, ma senza le capacità avanzate di reasoning o l'analisi dati complessa del tier Plus.

Questa mossa suggerisce una saturazione del segmento early adopter e la necessità di convertire l'utenza casual. I dettagli sulle limitazioni e i vantaggi sono trattati in Pubblicità su ChatGPT e il nuovo tier Go da 8€.

Sul fronte Google/DeepMind, Demis Hassabis in una delle sue ultime interview, afferma che Gemini App per ora non includerà pubblicità, ma che osserveranno attentamente gli sviluppi.

Deep Learning Theory: Pesi e Rappresentazioni

Sul fronte della ricerca teorica, due pubblicazioni hanno approfondito la comprensione di come le reti neurali manipolano le informazioni nel latent space.

Universal Weight Subspace Hypothesis

Un nuovo paper propone l'ipotesi del Sottospazio Universale dei Pesi. La teoria suggerisce che, indipendentemente dall'inizializzazione o dai dati specifici, i modelli che raggiungono prestazioni simili tendono a convergere verso sottospazi di pesi geometricamente affini! Questa scoperta potrebbe avere implicazioni concrete per il model merging, il transfer learning e la comprensione della loss landscape.

L'analisi tecnica delle dimostrazioni matematiche e delle implicazioni pratiche è disponibile qui: Universal Weight Subspace Hypothesis guida completa.

Fondamentali: AutoEncoder e PyTorch

Per chi si approccia alla costruzione di architetture generative o di compressione, l'AutoEncoder rimane un blocco costruttivo essenziale. Comprendere il flusso encoder-decoder, la riduzione della dimensionalità e la ricostruzione dell'input è propedeutico allo studio di architetture più complesse come i Variational AutoEncoders (VAE) o i Diffusion Models.

È stata pubblicata una guida che copre AutoEncoders con implementazione da zero: Cos'è un AutoEncoder? Guida completa.

Career e Management: Hiring ML Engineers

Guardando al 2026, il ruolo del Machine Learning Engineer sta evolvendo. Le aziende non cercano più solo esperti nella costruzione di modelli da zero, ma profili ibridi capaci di gestire l'intera pipeline MLOps, l'ottimizzazione dell'inferenza e l'integrazione di API LLM per dar vita a soluzioni dinamiche e flessibili.

Per hiring manager o per te che stai assumendo, dacci uno sguardo: Machine Learning Engineer: La Guida Definitiva per Trovare il Profilo Giusto nel 2026.