Liquid LFM-2.5-1.2B-Thinking: Novità e Guida completa

Local AI per tutti!

Liquid AI ha rilasciato LFM2.5-1.2B-Thinking, un modello da 1.2 miliardi di parametri sviluppato per l'esecuzione in locale. Il sistema è progettato per occupare circa 900 MB di memoria su smartphone, permettendo di gestire task di ragionamento interamente offline. Questa ottimizzazione consente di eseguire elaborazioni complesse direttamente sull'hardware dell'utente finale, eliminando la dipendenza dal cloud.

Metodologia "Chain-of-Thought"

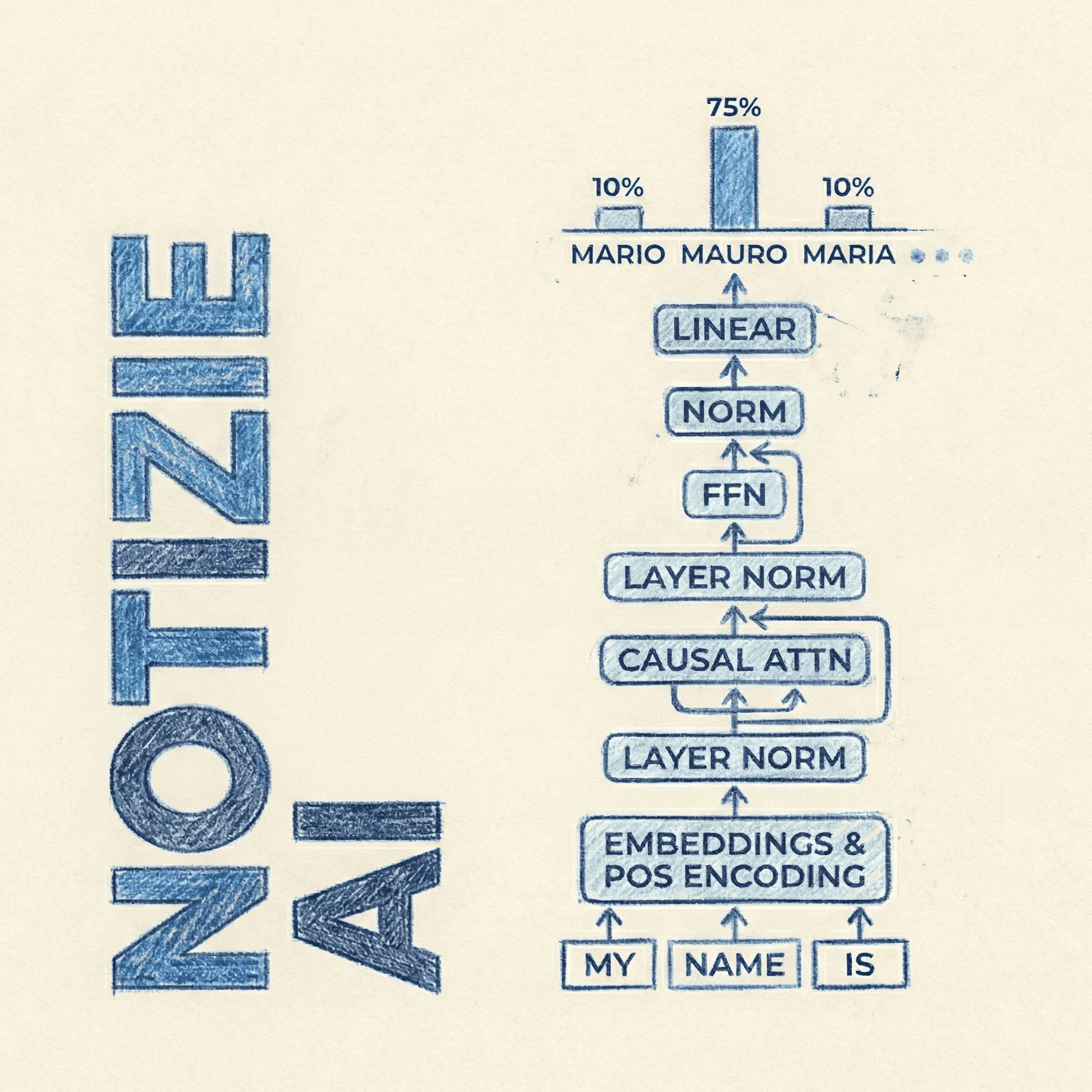

A differenza delle varianti standard basate su istruzioni, questo modello adotta l'oramai consolidato processo di "catena di pensiero" (chain-of-thought): genera tracce di ragionamento intermedie prima di produrre l'output finale. Questo approccio incrementa la precisione in ambito logico-matematico, portando il punteggio sul benchmark MATH-500 a 88 (contro il 63 della versione Instruct). I dati mostrano prestazioni competitive anche rispetto a modelli con più parametri, come Qwen3-1.7B, in particolare nella risoluzione di problemi strutturati.

Prestazioni on-device

L'architettura supporta diversi processori consumer, incluse le NPU Qualcomm Snapdragon, i chip Apple Silicon e AMD Ryzen. I test tecnici riportano velocità di inferenza elevate, con picchi di oltre 4000 token al secondo in fase di prefill su hardware mobile specifico, mantenendo stabilità anche su contesti lunghi fino a 32k token. Tali specifiche rendono il modello idoneo per applicazioni che richiedono bassa latenza, come l'interazione vocale in tempo reale o la robotica.

Processo di addestramento ibrido

Per bilanciare dimensioni ridotte e capacità di calcolo, è stata utilizzata una strategia di addestramento mista. Il modello combina il fine-tuning supervisionato su dati sintetici con un curriculum di Reinforcement Learning parallelo. Un aspetto tecnico rilevante è la gestione del "doom looping" (la tendenza a generare ragionamenti circolari): tramite l'applicazione di penalità mirate durante l'allineamento, il tasso di ripetizione è stato ridotto dal 15% a meno dello 0,4%, favorendo risposte più sintetiche.

Distribuzione e compatibilità

LFM2.5-1.2B-Thinking è distribuito come modello "open-weight" ed è compatibile nativamente con framework quali llama.cpp, MLX, vLLM e ONNX Runtime. Grazie alla collaborazione con produttori hardware come Qualcomm e AMD, il modello dispone di ottimizzazioni specifiche per le NPU attuali, facilitando l'integrazione tecnica sia in ambienti di sviluppo open source che in contesti commerciali.