GPT-5.2: novità, contesto e applicazioni pratiche del nuovo modello OpenAI

GPT-5.2 è il nuovo modello di frontiera di OpenAI pensato per il lavoro professionale e per agenti che restano attivi a lungo. Rispetto a GPT-5.1 migliora in modo marcato su fogli di calcolo, presentazioni, coding, visione e ragionamento su contesti lunghi (long context), riducendo anche le allucinazioni. In questo articolo vediamo che cos'è GPT-5.2, perché è importante nel panorama attuale e cosa cambia per chi usa ogni giorno ChatGPT e l'API.

Titolo originale: "Introducing GPT-5.2". Pubblicato l'11 dicembre 2025 sul sito OpenAI, nella sezione "Latest Advancements".

Che novità introduce GPT-5.2?

Che cos'è GPT-5.2 in parole semplici?

GPT-5.2 è la nuova generazione di large language models di OpenAI pensata per il professional knowledge work. L'obiettivo è aiutare persone e aziende a produrre documenti, analisi e codice con qualità più vicina a quella dei migliori esperti umani, ma con tempi e costi drasticamente ridotti.

La famiglia comprende tre varianti: GPT-5.2 Instant, più rapido e leggero, GPT-5.2 Thinking, ottimizzato per ragionamenti complessi, e GPT-5.2 Pro, il modello più potente e affidabile per i casi più critici. In ChatGPT queste varianti sono esposte come ChatGPT-5.2 Instant, Thinking e Pro, mentre nell'API appaiono come gpt-5.2-chat-latest, gpt-5.2 e gpt-5.2-pro.

Perché GPT-5.2 è rilevante oggi?

GPT-5.2 arriva in un momento di forte competizione tra modelli di frontiera, con Google Gemini 3 che ha spinto OpenAI a dichiarare internamente un "code red" per accelerare lo sviluppo. In questo contesto, GPT-5.2 vuole essere il modello di riferimento per il lavoro professionale: generare presentazioni, fogli di calcolo, analisi e codice non è più solo "demo impressionante", ma un pezzo centrale dei flussi di lavoro quotidiani.

Sul benchmark interno GDPval, che misura compiti di lavoro ben specificati in 44 professioni, GPT-5.2 Thinking batte o eguaglia professionisti di settore nel 70,9% dei casi, diventando il primo modello OpenAI a raggiungere o superare il livello di esperti umani su questa metrica. In più produce gli output oltre 11 volte più rapidamente e a meno dell'1% del costo storico degli esperti, a parità di compito, quando usato con supervisione umana.

Come si collega GPT-5.2 ai modelli che già conosci?

Per capire GPT-5.2 ha senso ricordare GPT-5: un sistema unificato con un modello "standard", un modello di ragionamento (GPT-5 Thinking) e un router in tempo reale che decide quale usare in base al tipo di richiesta e alla complessità. GPT-5.2 non sostituisce questo impianto, ma lo estende: è una nuova famiglia di modelli dentro il sistema GPT-5, con capacità potenziate proprio nei punti più critici per applicazioni reali, come tool calling, long context e coding.

In ChatGPT, GPT-5.2 è pensato per essere "sensibilmente migliore" nell'uso quotidiano: Instant più strutturato e chiaro nelle spiegazioni, Thinking più forte in programmazione e analisi di documenti lunghi, Pro come opzione "premium" per problemi davvero difficili, dove vale la pena attendere qualche secondo in più per una risposta più robusta.

Per chi sviluppa con l'API, GPT-5.2 Thinking e Pro introducono un nuovo livello di sforzo di ragionamento (reasoning effort) chiamato xhigh, pensato per i task dove la qualità è prioritaria, e mantengono la compatibilità con il sistema di routing e strumenti di GPT-5.

GPT-5.2 spiegato più in dettaglio

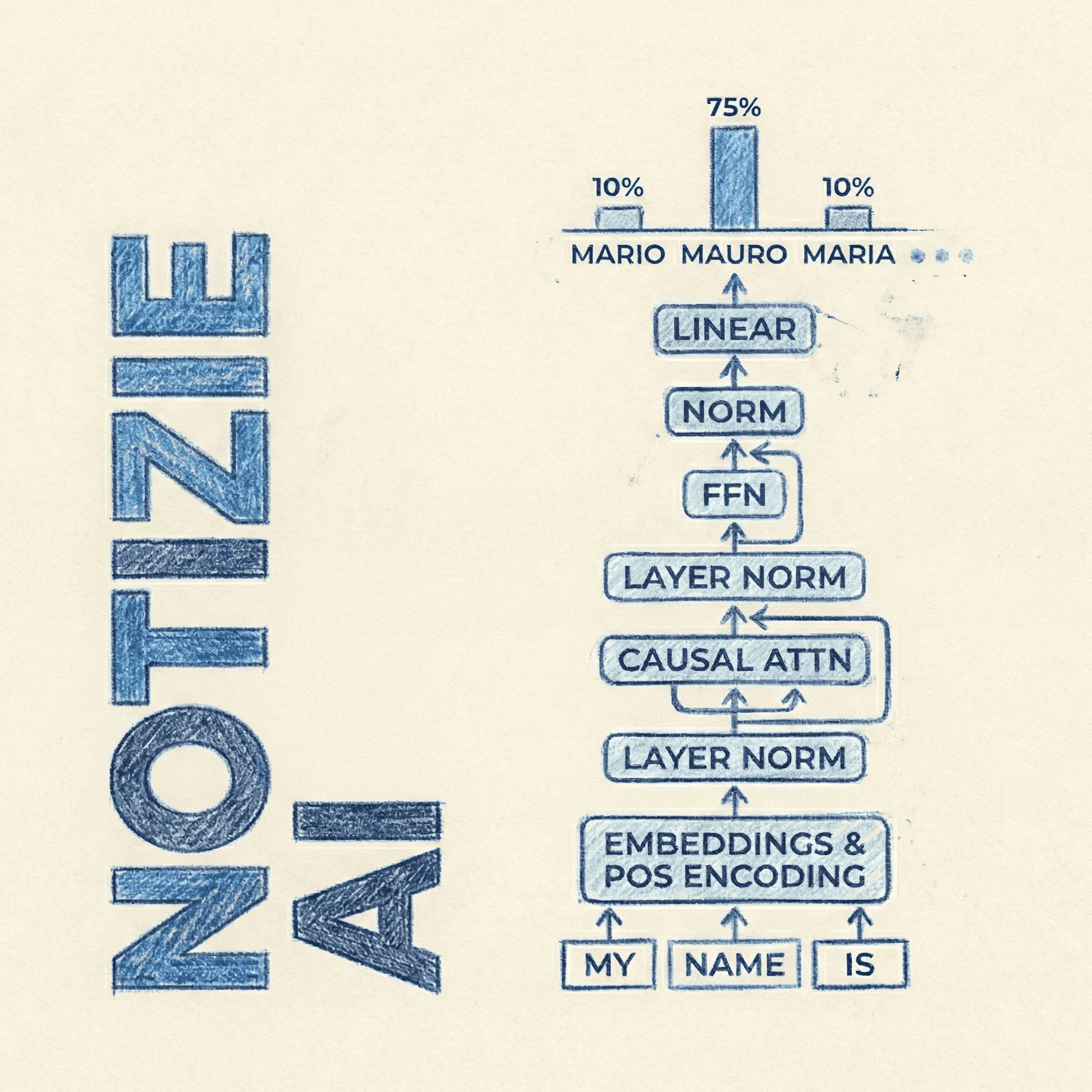

Architettura e componenti chiave

OpenAI non entra nei dettagli dell'architettura interna, ma chiarisce la struttura del prodotto: una serie di modelli compatibili con il sistema GPT-5, esposti in ChatGPT e in API con diversi profili di latenza e profondità di ragionamento. Instant è il "workhorse" veloce per domande, spiegazioni e testi tecnici; Thinking è l'opzione per flussi complessi e agenti; Pro è il modello di punta per casi in cui un errore ha un costo elevato.

Dal punto di vista del controllo, sviluppatori e utenti avanzati possono regolare il livello di sforzo di ragionamento (reasoning effort). GPT-5.2 introduce un quinto livello, xhigh, disponibile in Thinking e Pro, pensato per problemi in cui contano rigore, passaggi intermedi e correttezza più che la latenza.

Questa impostazione influisce su come il modello distribuisce "tempo computazionale" sul ragionamento interno.

Prestazioni e benchmark: quanto migliora rispetto a GPT-5.1?

Sul benchmark GDPval, GPT-5.2 Thinking non solo segna il nuovo massimo interno, ma distanzia nettamente GPT-5.1: passa da circa il 39% a quasi il 71% di vittorie o pareggi contro professionisti di settore, a seconda della variante di calcolo, con un salto particolarmente evidente nei casi di "vittoria chiara". È un indicatore concreto che GPT-5.2 è più capace di portare a termine compiti strutturati end-to-end.

Nel coding, GPT-5.2 Thinking ottiene il 55,6% su SWE-Bench Pro, un benchmark che misura la capacità di applicare patch a repository reali in più linguaggi, e raggiunge l'80% su SWE-bench Verified, migliorando i risultati di GPT-5.1. Nella pratica significa meno interventi manuali per refactoring, bug fixing e sviluppo di feature in codice di produzione, inclusi front-end complessi e interfacce 3D.

Long context, visione e agentic tool calling

Uno dei punti di forza dichiarati di GPT-5.2 è il ragionamento su contesti lunghi (long-context reasoning). Sul benchmark interno OpenAI MRCRv2, progettato per testare la capacità di integrare informazioni sparse su documenti molto lunghi, GPT-5.2 Thinking raggiunge prestazioni di stato dell'arte e sfiora il 100% su una variante a quattro "needle" fino a 256k token. In pratica, può analizzare contratti, report, trascrizioni o progetti multi-file mantenendo coerenza su centinaia di migliaia di token.

Per le applicazioni che superano persino questi limiti, GPT-5.2 Thinking è compatibile con l'endpoint /compact della Responses API, che permette di gestire workflow ancora più lunghi comprimendo in modo intelligente il contesto.

Questo è cruciale per agenti (agents) che devono richiamare strumenti (tool calling) molte volte su sessioni estese, per esempio per audit di codice o analisi legali complesse.

Sul fronte visione, GPT-5.2 Thinking dimezza circa il tasso di errore su benchmark come CharXiv Reasoning, che richiede di rispondere a domande su grafici scientifici, e ScreenSpot-Pro, che coinvolge screenshot di interfacce software. Il modello mostra anche una migliore comprensione del layout: individua regioni e componenti in immagini tecniche (come una motherboard) con bounding box molto più coerenti rispetto a GPT-5.1.

Infine, sul tool calling GPT-5.2 Thinking raggiunge il 98,7% su Tau2-bench Telecom, che misura la capacità di usare strumenti per risolvere casi di assistenza clienti multi-turno. OpenAI mostra un esempio in cui il modello gestisce da solo un caso complesso di volo in ritardo, connessione persa, pernottamento e richiesta di posto speciale, coordinando più azioni in sequenza con meno "rotture" del flusso rispetto a GPT-5.1.

Limiti, trade-off e costi di GPT-5.2

Nonostante i benchmark impressionanti, GPT-5.2 non è perfetto. OpenAI segnala esplicitamente che il modello continua a commettere errori e che, soprattutto in ambiti critici, è necessario un controllo umano e una doppia verifica dei risultati. Le allucinazioni sono ridotte rispetto a GPT-5.1, con un calo di circa il 30% delle risposte contenenti errori su query reali di ChatGPT, ma non sono azzerate.

Sul piano economico, in API GPT-5.2 costa più di GPT-5.1 per token: circa 1,75 dollari per milione di token in input e 14 dollari per milione in output per gpt-5.2, con forti sconti sui token in cache, mentre Pro ha prezzi significativamente più alti.

OpenAI però sottolinea che, per un dato livello di qualità, il costo complessivo può risultare inferiore grazie alla maggiore efficienza, cioè meno giri, meno prompt e meno correzioni necessarie.