OpenAI cerca un Head of Preparedness: 555k$ per gestire i rischi dei modelli di frontiera

Per caso I chatbot avanzati creano più problemi di quanti ne risolvano?

OpenAI ha aperto le candidature per una delle posizioni più delicate e critiche del momento: Head of Preparedness. Il ruolo, inserito nel team Safety Systems, prevede una retribuzione base di $555.000 (più equity) e segna un cambio di passo nella strategia di sicurezza dell'azienda. Non si tratta solo di policy, ma di una figura tecnica incaricata di gestire rischi concreti che, secondo Sam Altman, stanno emergendo rapidamente con le nuove generazioni di modelli.

Head of Preparedness OpenAI: perché ora?

L'urgenza di questa assunzione è sottolineata da un tweet di Sam Altman, che dipinge uno scenario complesso. Altman afferma esplicitamente che i modelli attuali stanno iniziando a trovare vulnerabilità critiche nella computer security e che nel 2025 abbiamo già visto "un'anteprima" del potenziale impatto di queste tecnologie sulla salute mentale.

Il messaggio è chiaro: siamo entrati in una fase in cui le frontier capabilities non sono più teoriche. I modelli stanno diventando abbastanza potenti da richiedere una comprensione sfumata di come queste capacità possano essere abusate, specialmente in ambiti come la cybersecurity (difensiva e offensiva) e la biosecurity.

Il ruolo e il Preparedness Framework

Il nuovo Head of Preparedness dovrà guidare la strategia tecnica ed esecutiva del Preparedness Framework. Questo framework è lo strumento con cui OpenAI traccia e si prepara ai rischi di "danno grave" (severe harm) derivanti dai modelli di frontiera.

Le responsabilità chiave includono:

- Capability Evaluations: Sviluppare valutazioni precise e scalabili per misurare le capacità dei modelli di frontiera attraverso cicli di prodotto rapidi.

- Threat Modeling: Stabilire modelli di minaccia per aree di rischio maggiori, come cyber e bio.

- Mitigations: Progettare salvaguardie tecnicamente solide che si allineino con i modelli di minaccia.

La figura dovrà operare all'intersezione tra ricerca, ingegneria e policy, garantendo che i risultati delle valutazioni influenzino direttamente le decisioni di lancio (launch decisions) e i safety cases.

Self-Improvement e rischi futuri

Un punto cruciale menzionato da Altman riguarda i sistemi in grado di auto-migliorarsi (self-improve). La sfida per il nuovo Head of Preparedness sarà permettere ai difensori della cybersecurity di utilizzare queste capacità avanzate per rendere i sistemi più sicuri, impedendo al contempo agli attaccanti di usarle per causare danni. È un equilibrio precario con "pochi precedenti", dove molte idee sulla carta presentano edge cases rischiosi nel mondo reale.

Requisiti e Compensazione

Il ruolo richiede un profondo giudizio tecnico in machine learning, AI safety e valutazioni di sicurezza. OpenAI cerca qualcuno capace di prendere decisioni high-stakes in condizioni di incertezza e di bilanciare la profondità scientifica con le realtà operative di un'azienda che spedisce prodotti velocemente.

L'offerta economica è significativa: $555K di stipendio base più un pacchetto di equity, a testimonianza di quanto questa figura sia centrale per la sostenibilità dei futuri rilasci di OpenAI.

Preparedness: Cosa ne pensa Mauro?

In passato la tecnologia serviva a risolvere problemi, da circa 10-15 anni siamo ufficialmente nel cosiddetto "late stage capitalism": chi sviluppa prodotti deve creare i bisogni per le persone, non risolverli. Ad oggi, se ci fate caso le uniche 2 aziende che fanno PR sulla questione sicurezza nel contesto dell'AI generativa sono OpenAI ed Anthropic. Google resta attiva, ma decisamente più realistica e meno complottista.

OpenAI la pone su un'ottica più "doom" e pessimistica. Ricordiamo che l'obiettivo di Sam Altman è trasformare il funzionamento dell'economia attuale grazie al raggiungimento dell'AGI, che essenzialmente lavorerà al posto nostro senza alcun tipo di supervisione umana. Ricordiamo anche il progetto Worldcoin di Altman, ed è bene ricordarlo perchè è tutto strettamente intrecciato.

Alla fine dei conti, l'obiettivo è sempre lo stesso: potere e manipolazione. Questa volta è diverso perchè il vero business è nascosto dietro un laboratorio di ricerca, che a tutti gli effetti produce la tecnologia perfetta sia per risolvere veri problemi e sia per insinuarsi nelle menti delle persone. Se pensavamo che l'end game, la cosiddettà "enshittification" fosse la pubblicità e gli algoritmi di tracciamento, ci sbagliavamo di grosso.

Nel frattempo Anthropic lavora e rilascia periodicamente aggiornamenti su mechanistic interpretability, cercando di tranquillizzare le persone sul fatto che è possibile comprendere gli LLM dopotutto.

La bolla oggettivamente esiste, è un nuovo mercato che si basa su concetti astratti e contraddittori, su disfattismo e creazione di nuovi sistemi economici, come se la visione dell'AGI fosse un qualcosa che è stato già accettato dalle persone.

La tecnologia resterà, la programmazione vedrà dopo 50 anni un'ulteriore layer di astrazione (l'inglese), la robotica farà passi da gigante, la scienza potrà progredire più velocemente.

Su questo non ho dubbi: le persone saranno sempre necessarie. I sistemi sono capaci e miglioreranno, ma la visione delle cose e le idee non nasceranno mai da sole senza il nostro input.

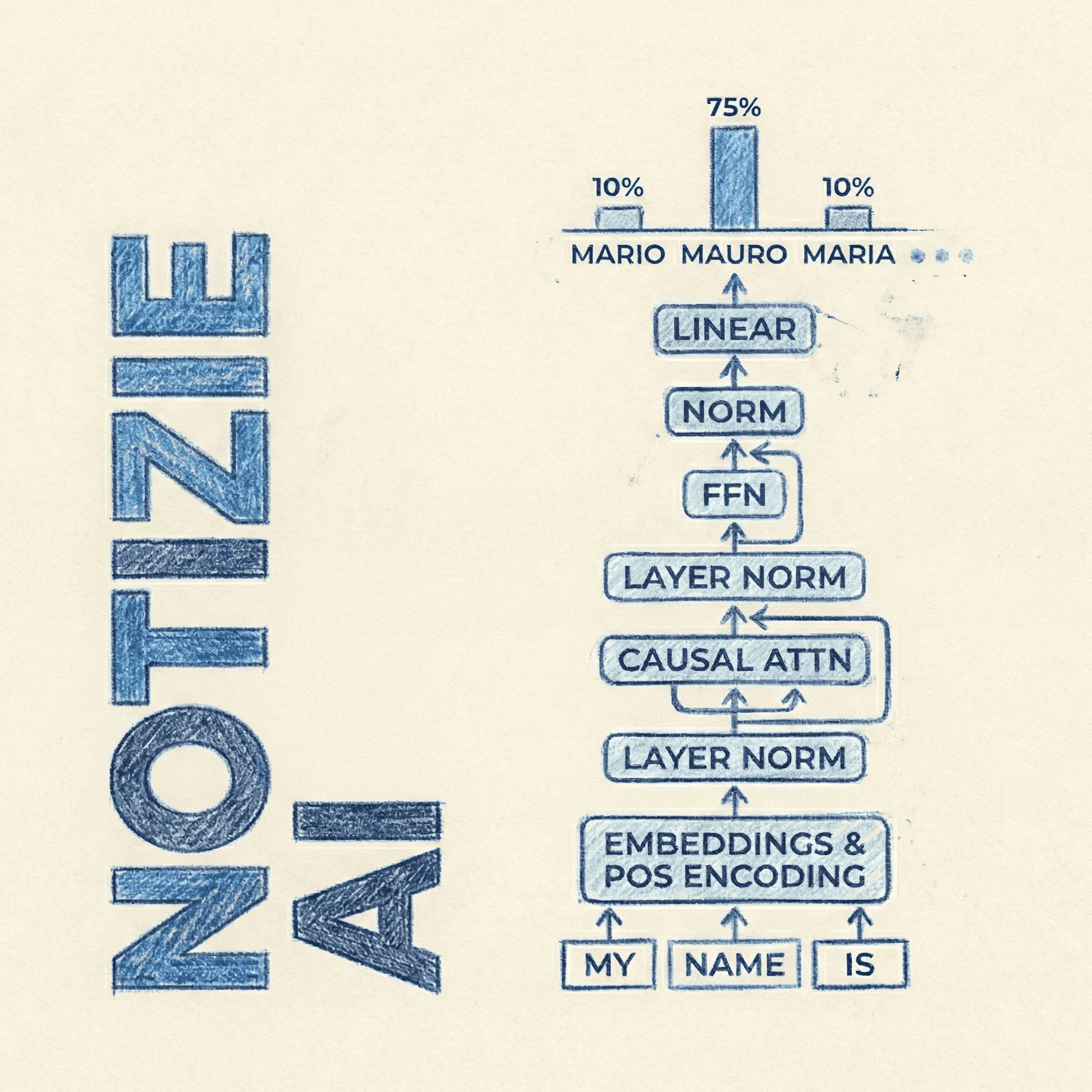

L'AI generativa non crea sequenze (idee) da zero, bensì continua il tuo prompt, la tua idea.

Focalizzatevi sul prompt, sui dettagli, sulle idee. Studiate e imparate come avete sempre fatto. L'AI vi permetterà di esplorare e crescere più in fretta.

Il reinforcement learning può ottimizzare tutto ciò che è verificabile, vero, ma come può ottimizzare l'obiettivo di creare di nuove idee? Come può dire se la tua idea, è valida o meno? Come può capire se la tua intuizione è esatta o meno?