Z-Image: Generazione Efficiente di Immagini con Single-Stream Diffusion Transformer

Generazione di immagini alla portata di tutti!

Cos'è Z-Image di Alibaba?

Z-Image rappresenta un importante passo avanti nel campo della generazione di immagini da testo (text-to-image generation). Sviluppato dal team Tongyi-MAI di Alibaba, questo modello dimostra che prestazioni di altissimo livello nella generazione di immagini fotorealistiche possono essere raggiunte senza dover ricorrere a modelli di dimensioni enormi. Con soli 6 miliardi di parametri, Z-Image riesce a produrre immagini di qualità comparabile a modelli commerciali che hanno un ordine di grandezza in più di parametri.

L'aspetto più interessante di questo lavoro è la sua efficienza computazionale: il modello può funzionare fluidamente su schede grafiche consumer con meno di 16GB di VRAM, rendendo la tecnologia di generazione avanzata accessibile a un pubblico molto più ampio. Il team ha rilasciato pubblicamente due varianti specializzate: Z-Image-Turbo per la generazione rapida e Z-Image-Edit per l'editing di immagini. Entrambe le varianti eccellono nella generazione fotorealistica e nel rendering bilingue di testo (inglese e cinese).

Secondo le valutazioni basate su Elo Human Preference (condotte su AI Arena), Z-Image mostra prestazioni altamente competitive rispetto ad altri modelli leader, raggiungendo risultati state-of-the-art tra i modelli open-source. La variante Z-Image-Turbo raggiunge o supera i principali competitor utilizzando solo 8 NFE (Number of Function Evaluations), con latenza di inferenza inferiore al secondo su GPU H800.

Repository GitHub: Il codice e i pesi del modello sono disponibili pubblicamente su https://github.com/Tongyi-MAI/Z-Image, incoraggiando l'esplorazione e l'uso da parte della comunità.

Approcci, tecniche e architettura di Z-Image

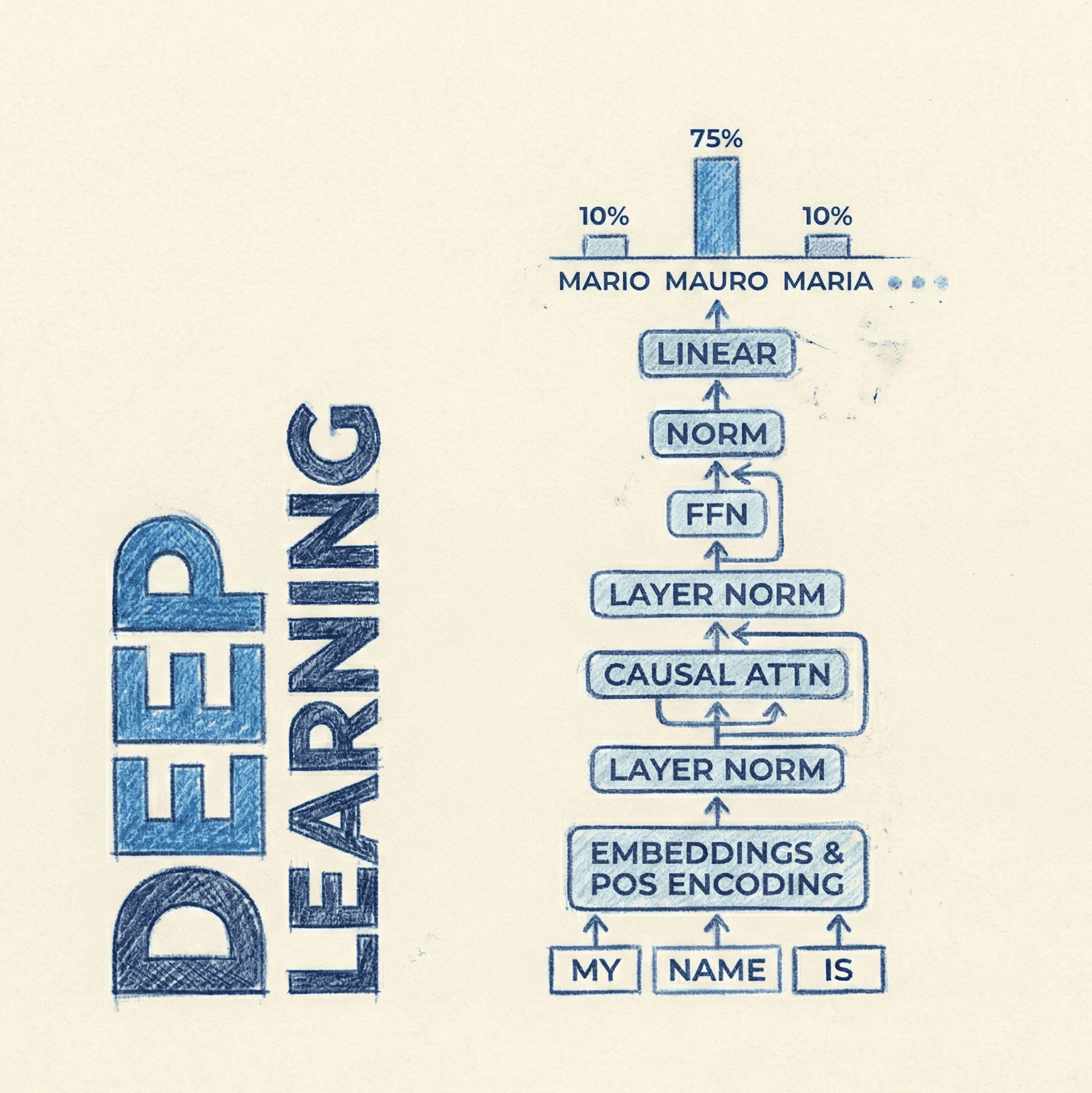

Il cuore innovativo di Z-Image risiede nella sua architettura Single-Stream Diffusion Transformer. Questo design unifica l'elaborazione di vari input (come embeddings di testo e immagine) con i latent dell'immagine in un'unica sequenza, che viene poi passata al backbone Transformer.

A differenza delle architetture tradizionali che mantengono flussi residuali separati per ogni modalità, l'approccio single-stream consente un'elaborazione più efficiente e integrata delle informazioni multimodali. Questa scelta architetturale si ispira ai recenti progressi nei Diffusion Transformers (DiT), che hanno sostituito le U-Net con Vision Transformer nei modelli di diffusione, operando nello spazio latente per una generazione efficiente e di alta qualità.

Operazioni nello Spazio Latente

Come altri modelli di diffusione avanzati, Z-Image opera principalmente nello spazio latente piuttosto che direttamente sullo spazio dei pixel. Questo approccio prevede tre componenti principali: un autoencoder che comprime le immagini in rappresentazioni più piccole, un processo di diffusione che aggiunge e rimuove rumore nello spazio latente, e un Transformer che prevede il rumore da rimuovere.

L'efficienza computazionale derivante dall'operare nello spazio latente è significativamente inferiore rispetto a modelli precedenti, i quali richiedevano centinaia di Gflops per forward pass. I Diffusion Transformer moderni richiedono una frazione di quella potenza computazionale.

Distillazione e Ottimizzazione

La variante Z-Image-Turbo è una versione distillata del modello base Z-Image. La distillazione è una tecnica che permette di trasferire la conoscenza da un modello più grande (teacher) a uno più piccolo e veloce (student), mantenendo prestazioni comparabili. Nel caso di Z-Image-Turbo, questa ottimizzazione permette di ottenere risultati eccellenti con solo 8 step di inferenza, riducendo drasticamente i tempi di generazione.

Prompt Enhancer con Reasoning Chain

Una componente distintiva di Z-Image è il Prompt Enhancer (PE). Questo sistema utilizza una catena di ragionamento strutturata per iniettare logica e buon senso, permettendo al modello di gestire compiti complessi che richiedono comprensione contestuale. Anche quando le istruzioni dell'utente sono ambigue, il modello può applicare le sue capacità di ragionamento per inferire l'intento sottostante e garantire risultati logicamente coerenti.

Capacità Bilingue e Conoscenza Globale

Z-Image è stato addestrato con dati sia in inglese che in cinese, conferendogli eccezionali capacità nel rendering accurato di testo in entrambe le lingue. Inoltre, il modello possiede una vasta "world knowledge", permettendogli di generare accuratamente una vasta gamma di soggetti, inclusi punti di riferimento famosi, personaggi noti e oggetti specifici del mondo reale.

Z-Image: Risultati e prestazioni

Generazione Fotorealistica

Z-Image-Turbo eccelle nella produzione di immagini con realismo a livello fotografico, dimostrando un controllo fine su dettagli, illuminazione e texture. Il modello bilancia alta fedeltà, con forte qualità estetica nella composizione e nell'atmosfera generale, producendo immagini che non sono solo realistiche ma anche visivamente accattivanti.

Le valutazioni comparative mostrano che Z-Image-Turbo produce risultati comparabili ai migliori modelli closed-source, pur mantenendo dimensioni significativamente più ridotte.

Rendering di Testo e Poster

Una delle capacità più notevoli di Z-Image-Turbo è il suo accurato rendering di testo cinese e inglese preservando il realismo facciale e la composizione estetica complessiva. Nella realizzazione di poster, il modello dimostra forti abilità compositive e un buon senso tipografico, riuscendo a renderizzare testo di alta qualità anche in scenari impegnativi con dimensioni di carattere ridotte.

Prestazioni di Z-Image-Edit

La variante Z-Image-Edit, specializzata nell'editing di immagini, può eseguire precisamente istruzioni complesse come cambiare e schiarire simultaneamente lo sfondo. Può anche modificare testo in posizioni specificate e mantenere la consistenza dei caratteri durante trasformazioni significative dell'immagine, dimostrando un controllo fine sugli elementi dell'immagine.

Efficienza Computazionale

Un risultato chiave è l'accessibilità del modello: Z-Image può funzionare su hardware consumer con meno di 16GB di VRAM, democratizzando l'accesso a tecnologia di generazione di immagini di livello enterprise. Z-Image-Turbo raggiunge latenza di inferenza sub-secondo su GPU H800, rendendolo pratico per applicazioni in tempo reale.

Valutazione su AI Arena

Secondo le valutazioni Elo-based Human Preference condotte su AI Arena, Z-Image mostra prestazioni altamente competitive contro altri modelli leader, raggiungendo risultati state-of-the-art tra i modelli open-source. Questo tipo di valutazione è particolarmente significativo perché riflette preferenze umane reali piuttosto che metriche automatiche che potrebbero non catturare completamente la qualità percettiva.

Concetti fondamentali da comprendere per Z-Image

Diffusion Models e Denoising Process

I diffusion models sono una classe di modelli generativi che apprendono attraverso un processo iterativo di denoising. Durante l'addestramento, il modello apprende come il rumore viene progressivamente aggiunto a immagini reali (forward diffusion process). Durante l'inferenza, il processo viene invertito: partendo da rumore casuale, il modello lo rimuove iterativamente fino a produrre un'immagine coerente, condizionata dal prompt.

Vision Transformers nei Diffusion Models

I Diffusion Transformers (DiT) rappresentano un'evoluzione rispetto alle architetture U-Net tradizionalmente usate nei diffusion models. I Transformer processano l'immagine come una sequenza di patch (token), permettendo una maggiore scalabilità e flessibilità nell'elaborazione di informazioni condizionali.

Nel contesto di Z-Image, l'architettura single-stream permette di processare simultaneamente embeddings di testo, embeddings di immagine e latent rumorosi in un'unica sequenza unificata, facilitando l'integrazione multimodale.

Adaptive Layer Normalization (AdaLN)

Una tecnica cruciale nei Diffusion Transformer è l'Adaptive Layer Normalization (AdaLN). Invece di semplicemente concatenare i vettori condizionali (per timestep, classe, etc.) ai token di input, questi vengono prima processati da un MLP per produrre parametri di scale (γ) e shift (β). Questi parametri vengono poi usati per modulare le attivazioni all'interno di ogni blocco DiT, subito dopo la Layer Normalization, permettendo alle informazioni condizionali di influenzare dinamicamente le computazioni della rete a ogni layer.

Spazio Latente vs Spazio dei Pixel

Operare nello spazio latente significa lavorare con rappresentazioni compresse delle immagini piuttosto che con i pixel originali. Un autoencoder (tipicamente un VAE - Variational Autoencoder) comprime prima le immagini in rappresentazioni molto più piccole. Il processo di diffusion avviene poi in questo spazio compresso, riducendo drasticamente i requisiti computazionali.

Questa scelta architetturale permette di ridurre i Gflops necessari per forward pass di ordini di grandezza rispetto a modelli che operano direttamente sullo spazio dei pixel.

Cross-Attention per Conditioning

Il meccanismo di cross-attention è fondamentale per integrare le informazioni testuali nel processo di generazione. La cross-attention combina informazioni da due modalità diverse. Permette al modello di associare parole rilevanti nel testo alle corrispondenti regioni nell'immagine, guidando efficacemente il processo generativo.

Model Distillation

La distillazione è una tecnica che permette di creare modelli più piccoli e veloci (student) che imitano il comportamento di modelli più grandi (teacher). Nel caso di Z-Image-Turbo, la distillazione ha permesso di ridurre significativamente il numero di step necessari per la generazione (da decine a solo 8), mantenendo qualità comparabile. Questo è cruciale per applicazioni che richiedono generazione rapida in tempo reale.

Quiz: domande e risposte

Studi correlati e contesto

Scalable Diffusion Models with Transformers (DiT)

Il paper originale sui Diffusion Transformers ha introdotto l'idea di sostituire le U-Net con Vision Transformer nei diffusion models. Questo lavoro ha dimostrato che i Transformer scalano meglio con l'aumento dei parametri e dei dati di training, raggiungendo FID (Fréchet Inception Distance) di 2.27 su ImageNet a 256x256 con significativamente meno Gflops rispetto a modelli precedenti. Z-Image si basa su questi principi architetturali, estendendoli con l'approccio single-stream.

Stable Diffusion e Latent Diffusion Models

Latent Diffusion Models (LDM), di cui Stable Diffusion è l'implementazione più nota, hanno rivoluzionato il campo introducendo l'operazione nello spazio latente. Questi modelli utilizzano un autoencoder per comprimere le immagini, eseguono la diffusion nello spazio compresso, e poi decodificano i risultati nello spazio dei pixel. Z-Image adotta e ottimizza questo approccio, dimostrando che efficienza ancora maggiore può essere raggiunta con architetture appropriate.

CLIP e Text Encoding

CLIP (Contrastive Language-Image Pre-training) è fondamentale per molti modelli text-to-image moderni, incluso Z-Image. CLIP apprende rappresentazioni robuste che catturano sia semantica che stile, permettendo ai modelli di comprendere e generare immagini basate su descrizioni testuali complesse. Il text encoder di Z-Image probabilmente utilizza embeddings simili a CLIP per processare i prompt testuali.

Flux e SD3: Multi-Stream vs Single-Stream

Modelli recenti come Flux e Stable Diffusion 3 hanno esplorato diverse architetture per l'integrazione multimodale. Mentre alcuni mantengono flussi residuali separati per ogni modalità (dual-stream), altri come Z-Image utilizzano un approccio single-stream che unifica tutte le modalità in una sequenza unica. La scelta tra questi approcci rappresenta un trade-off tra specializzazione modulare ed efficienza di elaborazione integrata.

HiDream-I1: Sparse DiT Architecture

HiDream-I1 rappresenta un approccio alternativo all'efficienza, utilizzando una struttura DiT sparsa con architettura dynamic Mixture-of-Experts (MoE). Inizia con un design dual-stream decoupled per processare indipendentemente token di immagine e testo, poi adotta una struttura DiT single-stream sparsa per l'interazione multi-modale. Questo dimostra che esistono molteplici strade per raggiungere efficienza nei diffusion models.

Zero-Shot Image Editing

Lavori come pix2pix-zero e CycleDiffusion hanno esplorato l'editing di immagini zero-shot usando diffusion models pre-addestrati senza fine-tuning. Z-Image-Edit estende queste idee con capacità di seguire istruzioni complesse e mantenere consistenza durante trasformazioni significative, dimostrando come modelli specializzati possano migliorare specifici task mantenendo l'efficienza generale.

Generazione di Concetti Rari

Ricerche come SeedSelect hanno affrontato il problema della generazione di concetti sotto-rappresentati nei dati di training. Questo è rilevante per Z-Image perché la vasta comprensione della conoscenza del mondo del modello suggerisce strategie efficaci per gestire la distribuzione long-tail dei concetti nei dataset. La capacità di generare accuratamente landmarks famosi, personaggi noti e oggetti specifici indica che Z-Image ha probabilmente beneficiato di strategie simili durante il training.

Riferimenti e link utili

- GitHub - Tongyi-MAI/Z-Image

- Articolo

- Tongyi-MAI/Z-Image-Turbo · Hugging Face

- ConceptAttention: Diffusion Transformers Learn Highly Interpretable Features

- Diffusion Transformers Explained: The Beginnerâs Guide

- Text-to-image: latent diffusion models

- Scalability of Diffusion Models with Transformer Backbone | Encord

- Reddit - The heart of the internet

- Articolo

- [2505.22705] HiDream-I1: A High-Efficient Image Generative Foundation Model with Sparse Diffusion Transformer

- [2302.03027] Zero-shot Image-to-Image Translation

- Articolo

- Generating images of rare concepts using pre-trained diffusion models

- Z-Image Turbo Image Model | aicreators.tools

- Reddit - The heart of the internet

- Tongyi-MAI (Tongyi-MAI)

- Tongyi DeepResearch 30B A3B Free Chat Online - Skywork ai

- Articolo

- Replicate - Run AI with an API

- [1902.06068] Deep Learning for Image Super-resolution: A Survey

- Articolo

- Articolo

- Integrating image processing with deep convolutional neural networks for gene selection and cancer classification using microarray data | Scientific Reports

- Z-Image-Gallery

- Text-to-image Diffusion Models in Generative AI: A Survey

- Articolo

- Models - Hugging Face

- prunaai/z-image-turbo | Run with an API on Replicate

- Articolo

- Reddit - The heart of the internet

- ZeST: Zero-Shot Material Transfer from a Single Image

- Articolo

- Training on a different dataset - Intrinsic parameters · Issue #6 · nianticlabs/monodepth2 · GitHub

- [2411.19231] Z-STAR+: A Zero-shot Style Transfer Method via Adjusting Style Distribution

- [2501.15743] Z-Stack Scanning can Improve AI Detection of Mitosis: A Case Study of Meningiomas

- Articolo

- Articolo

- Multi-Modal Diffusion Transformers