TranslateGemma: Guida completa del nuovo modello open per la traduzione AI

TranslateGemma è una suite di modelli aperti basati su Gemma 3, ottimizzati per la traduzione.

TranslateGemma è una nuova famiglia di modelli di traduzione "open weights" costruiti a partire dai foundation model Gemma 3. L'obiettivo è colmare il divario tra i modelli generalisti e i sistemi di traduzione specializzati, mantenendo al contempo le capacità multimodali.

Gli autori introducono un approccio di fine-tuning a due stadi: inizialmente viene eseguito un Supervised Fine-Tuning (SFT) su un mix di dati paralleli umani e sintetici di alta qualità (generati da Gemini), seguito da una fase di Reinforcement Learning (RL) che utilizza reward models avanzati come MetricX-QE per ottimizzare direttamente la qualità della traduzione senza supporto umano. I modelli, rilasciati nelle taglie 4B, 12B e 27B, dimostrano prestazioni superiori alle baseline e competitività con modelli proprietari più grandi.

- Code: /

- Paper: https://arxiv.org/abs/2601.09012

- HuggingFace: https://huggingface.co/google/translategemma-4b-it

Obiettivi e Domande di Ricerca per Translate Gemma

- È possibile ottenere prestazioni di traduzione SOTA (State-of-the-Art) utilizzando modelli "open" di dimensioni ridotte rispetto ai giganti proprietari? Sì. I risultati mostrano che TranslateGemma 12B supera il modello base Gemma 3 27B e compete con modelli molto più grandi su benchmark come WMT24++, dimostrando che un fine-tuning specializzato può compensare la minor capacity.

- Come si può sfruttare efficacemente la generazione di dati sintetici per migliorare la traduzione nei modelli open? Il paper dimostra che l'uso di dati sintetici generati da modelli "insegnanti" avanzati (come Gemini 2.5 Flash), filtrati rigorosamente tramite metriche di stima della qualità (Quality Estimation), è cruciale. Questo processo di "distillazione" delle capacità di traduzione nel set di addestramento SFT permette al modello studente di apprendere pattern di traduzione di alta qualità.

- L'ottimizzazione specifica per la traduzione compromette le capacità multimodali native del modello base? No. TranslateGemma mantiene le capacità multimodali di Gemma 3. I test sul benchmark Vistra (traduzione visiva) indicano che il miglioramento nella traduzione testuale si trasferisce positivamente anche alla traduzione di testo contenuto nelle immagini, senza un training multimodale specifico durante la fase di specializzazione.

Translate Gemma: Metodi e tecniche

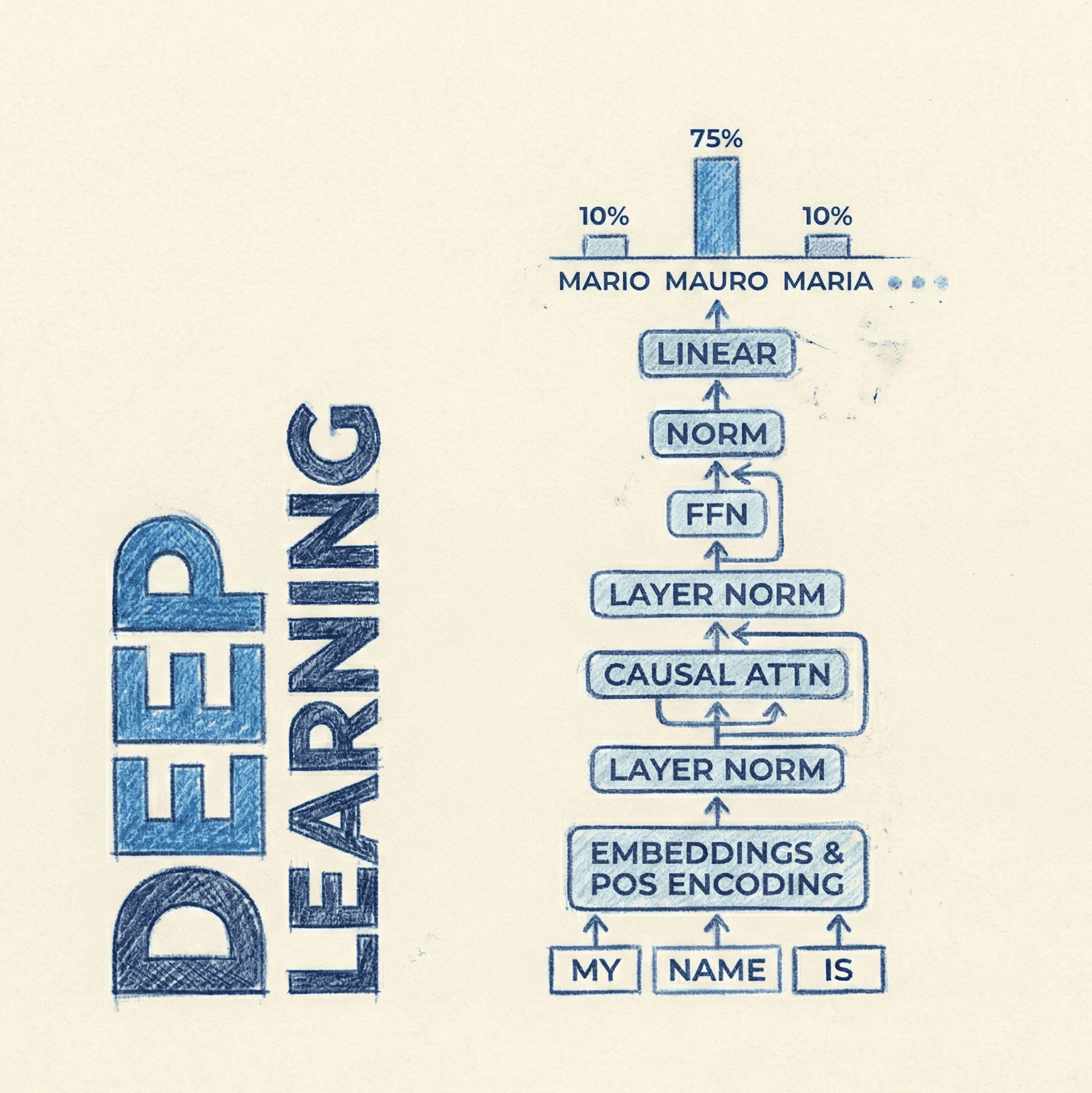

Il successo di TranslateGemma si basa su una ricetta di post-training a due stadi applicata a Gemma 3:

1. Supervised Fine-Tuning (SFT) con "Knowledge Distillation"

La prima fase consiste in un fine-tuning supervisionato classico, ma con un twist. Oltre ai dataset curati (bitext), gli autori utilizzano una vasta quantità di dati sintetici.

Il processo di generazione prevede:

- Campionamento di frasi sorgente (source).

- Traduzione tramite un modello "teacher" potente (e.g., Gemini 2.5 Flash).

- Filtraggio tramite Quality Estimation (QE): viene utilizzato MetricX-24-QE per selezionare solo le coppie in cui la traduzione sintetica porta un miglioramento tangibile rispetto a una baseline.

La loss function è la standard cross-entropy loss: Dove è il prompt (testo o immagine + istruzione) e è la traduzione target.

2. Reinforcement Learning (RL) con Quality Estimation Rewards

La seconda fase utilizza il Reinforcement Learning per allineare ulteriormente il modello verso la qualità della traduzione. A differenza dei metodi classici che richiedono reference umane (come BLEU), qui si usano Reward Models (RMs) basati su reti neurali che stimano la qualità senza bisogno di un riferimento (reference-free):

- MetricX-QE: Un modello di stima della qualità allo stato dell'arte.

- AutoMQM: Un modello predittivo addestrato per mimare le valutazioni umane basate sullo standard MQM (Multidimensional Quality Metrics).

L'algoritmo di RL (probabilmente una variante di GRPO con token-level advantages, citando lavori come Ramos et al., 2025) ottimizza il modello per massimizzare il reward atteso: Dove è il punteggio fornito dall'ensemble dei reward models. Questo permette al modello di superare i limiti dei dati di training statici, esplorando traduzioni che massimizzano la qualità percepita.

Dataset di training e test usati per TranslateGemma

Il training sfrutta una combinazione massiva di fonti:

- Dati Curati: Raccolti da fonti web pubbliche e filtrate.

- Dati Sintetici: Generati utilizzando Gemini 2.5 Flash come teacher. Per ogni coppia linguistica, vengono generati fino a 10.000 esempi sintetici di alta qualità, selezionati tramite MetricX 24-QE.

Per la valutazione sono stati utilizzati benchmark standard e nuovi:

- WMT25: Utilizzato per la valutazione umana su 10 coppie linguistiche.

- WMT24++: Un benchmark interno per la valutazione automatica su 55 coppie linguistiche.

- Vistra: Benchmark per valutare le capacità di traduzione multimodale (testo all'interno di immagini).

Licenze d'utilizzo di Translate Gemma

I modelli TranslateGemma sono rilasciati come Open Models. Solitamente, la famiglia Gemma è soggetta ai Gemma Terms of Use, una licenza permissiva che consente l'uso commerciale, la distribuzione e la modifica, pur con alcune restrizioni relative all'uso responsabile e alla sicurezza (Safety).