Step-DeepResearch: Analisi tecnica del modello che sfida OpenAI con "soli" 32B parametri

Modello da 32B parametri che eguaglia le prestazioni di ricerca di OpenAI e Gemini.

In Step-DeepResearch Technical Report (arxiv:2512.20491) il team di StepFun presenta un modello da 32 miliardi di parametri progettato per compiti di "Deep Research" (ricerca approfondita a lungo orizzonte). L'approccio sfida il fatto che siano necessari modelli enormi per la ricerca complessa.

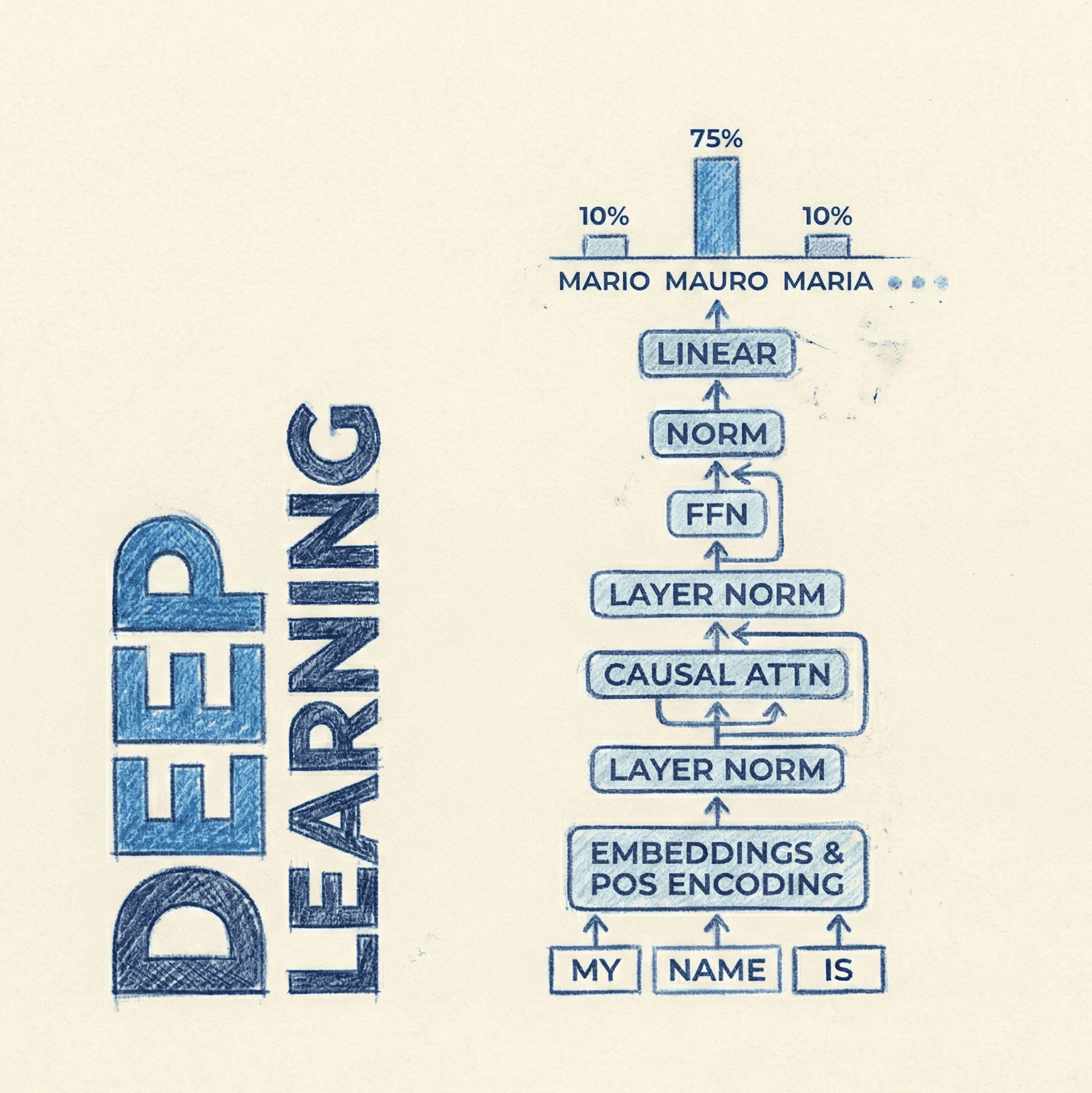

Il core del lavoro è una strategia di sintesi dei dati basata su Atomic Capabilities (capacità atomiche) come pianificazione, raccolta informazioni e scrittura di report. Invece di addestrare il modello su intere traiettorie rumorose, gli autori scompongono il processo in skill fondamentali, addestrate progressivamente tramite un percorso che va dal mid-training agentico, al Supervised Fine-Tuning (SFT) fino al Reinforcement Learning (RL). Il modello utilizza un'architettura a singolo agente in stile ReAct e viene valutato su un nuovo benchmark, ADR-Bench, dimostrando efficienza e qualità paragonabili a modelli closed-source molto più grandi.

- Code: /

- Paper: https://arxiv.org/abs/2512.20491

- Dataset: / (ADR-Bench menzionato ma repository non pubblico)

- HuggingFace: https://huggingface.co/papers/2512.20491

Step-DeepResearch: Obiettivi di ricerca

Il paper risponde principalmente a queste tre domande di ricerca:

- È possibile ottenere capacità di "Deep Research" con modelli di medie dimensioni (32B)? Sì. Attraverso un curato processo di sintesi dei dati e un training focalizzato sulle "capacità atomiche", Step-DeepResearch supera modelli open-source più grandi e rivaleggia con sistemi proprietari come OpenAI Deep Research e Gemini Deep Research.

- Come si costruisce un dataset efficace per agenti di ricerca autonomi? Non basta raccogliere log di navigazione umana. Il paper propone di sintetizzare dati focalizzati su skill specifiche (pianificazione, query, lettura) e di applicare una pulizia rigorosa: mantenere solo le traiettorie "corrette e più brevi" ed eliminare i pattern cognitivi ripetitivi, iniettando però "rumore strutturato" (es. errori nei tool) per aumentare la robustezza.

- Qual è la pipeline di addestramento ottimale per questi agenti? Gli autori propongono un percorso progressivo a tre stadi:

- Agentic Mid-training: Esposizione massiccia a dati sintetici di skill atomiche.

- Post-training SFT: Raffinamento per il "cold start" e l'imitazione di comportamenti corretti.

- Reinforcement Learning (RL): Ottimizzazione finale con un reward model basato su una "Checklist" di criteri qualitativi.

Step-DeepResearch: Cosa ne pensa Mauro

- Novità: 2.5/5. L'aspetto più interesssante non è l'architettura (che rimane un LLM denso standard), ma la Data Synthesis Strategy. L'idea di disaccoppiare il "pensiero" in capacità atomiche (planning, retrieval, reflection) e sintetizzare dati specifici per ognuna, unita a un "Checklist-style Judger" per il reward nel RL, rappresenta un contributo significativo per l'addestramento di agenti efficienti. Comunque sia, nulla di sconvolgente.

- Chiarezza: 4/5. Il report è denso ma ben strutturato. Spiega chiaramente la filosofia dietro la costruzione del dataset (es. rimozione di traiettorie ridondanti, iniezione di rumore controllato), rendendo la metodologia comprensibile anche se complessa.

- Riproducibilità: 1/5. Sebbene il metodo sia descritto, il modello (pesi), il codice di training e i dataset sintetici generati non sono stati rilasciati pubblicamente. Anche il benchmark ADR-Bench citato non sembra avere un link pubblico attivo al momento della stesura.

- Accessibilità: 1/5. Per un ricercatore indipendente, riprodurre questo lavoro è molto difficile. Richiede la generazione di enormi quantità di dati sintetici (probabilmente usando LLM molto capaci come "insegnanti") e l'accesso a infrastrutture di ricerca web su larga scala per il training e la validazione. Il modello finale (32B) è però gestibile in inferenza su hardware prosumer (es. 2x A100 o 4x 3090/4090 con quantizzazione). Ormai grande classico dell'era LLM.

Step-DeepResearch: Metodi e tecniche

Le tecniche presentate in Step-DeepResearch si concentrano sulla pipeline di addestramento e sulla costruzione dei dati.

Atomic Capability Data Synthesis

Invece di addestrare il modello genericamente su "web browsing", il task viene decomposto. Il modello viene addestrato a padroneggiare singole abilità. Possiamo immaginare la struttura dei dati di training come una collezione di tuple focalizzate su specifici step del ciclo ReAct:

- Planning: Scomporre una query utente complessa in sotto-task.

- Information Gathering: Generare query di ricerca efficaci e selezionare le fonti.

- Reflection & Correction: Analizzare i risultati e decidere se sono sufficienti o se serve correggere il tiro.

- Reporting: Sintetizzare le informazioni raccolte in un formato accademico con citazioni.

Per pulire questi dati, applicano il principio "Correct and Shortest": Se esistono più traiettorie di ricerca che portano alla risposta corretta, viene mantenuta solo quella con meno step, per insegnare al modello l'efficienza.

Progressive Training Pipeline

La pipeline è composta da tre fasi distinte. Se dovessimo rappresentare lo pseudo-codice dell'algoritmo di training RL (fase 3), che è la parte più critica per l'allineamento, apparirebbe così:

# Pseudo-code del loop di Reinforcement Learning con Checklist Judger

def train_step_rl(agent, prompt, environment):

# L'agente genera una traiettoria completa (pensieri + azioni)

trajectory = agent.generate_rollout(prompt)

# Il Judger valuta la traiettoria basandosi su una checklist

# Esempi di criteri: "Ha risposto alla domanda?", "Le citazioni sono corrette?",

# "Ha evitato loop infiniti?"

reward_score = checklist_judger.evaluate(

trajectory.final_answer,

trajectory.search_logs,

ground_truth=None # Spesso valutato solo sulla qualità del processo

)

# Aggiornamento dei pesi tramite algoritmo RL (es. PPO o varianti)

# L'obiettivo è massimizzare il reward atteso

loss = ppo_loss(agent.policy, trajectory, reward_score)

optimizer.step(loss)

return loss

Checklist-style Judger

A differenza dei reward model classici che danno un singolo scalare, il loro "Judger" valuta l'output finale basandosi su una lista di controllo gerarchica. Questo permette di dare feedback più granulari (es. penalizzare pesantemente le allucinazioni nelle citazioni, ma essere più indulgenti sullo stile di scrittura) permettendo di avere un reward meno sparsom, agevolando la fase RL.

Step-DeepResearch: Dataset

Il report fa riferimento a due tipologie di dati principali:

- Synthetic Training Data: Generati internamente decomponendo task complessi. Include meccanismi di deduplicazione N-gram per evitare che il modello impari loop ripetitivi, e iniezione di rumore (es. simulare un motore di ricerca che restituisce risultati vuoti) per insegnare al modello a reagire agli errori.

- ADR-Bench (Agentic Deep Research Benchmark): Un nuovo benchmark introdotto dagli autori per colmare il divario nella valutazione tra siti cinesi e anglofoni, oltre che includere task di ricerca realistici. Include scenari che richiedono riconoscimento dell'intento latente e verifica incrociata delle fonti. Purtroppo, non è fornito un link pubblico diretto al dataset nel report.

Step-DeepResearch: Licenze

Il paper non specifica esplicitamente una licenza open source (come MIT o Apache 2.0) per i pesi del modello o per il codice. Essendo un "Technical Report" di un'azienda privata (StepFun), e data l'assenza di link a repository pubblici nel paper, si deve assumere che il modello e i dati siano proprietari e non rilasciati liberamente.