Notizie AI della 3ª settimana di dicembre 2025 (15-21 dicembre)

In questo report settimanale su mauroscIA, diamo un occhio alle ultime notizie AI e Deep Learning emerse tra il 15 e il 21 dicembre 2025.

Questa settimana vediamo Sigma-MoE sfidare le leggi dello scaling con soli 500M parametri attivi e Bolmo dimostrare che è possibile eliminare i tokenizer lavorando direttamente sui byte. Sul fronte teorico abbiamo EFLA che corregge gli errori dell'attenzione lineare e in computer vision Pixio che sposta la supervisione visiva al livello del singolo pixel (MAE, migliorata).

Gemini 3 Flash: Latenza e ragionamento in produzione

Google ha aggiornato la sua linea di modelli efficienti. La guida a Gemini 3 Flash si concentra sulle specifiche di latenza e throughput. Il modello è progettato per colmare il divario tra modelli "lite" e modelli "pro", offrendo capacità di ragionamento avanzate (math, coding, logic) a una velocità compatibile con applicazioni in tempo reale e assistenti vocali.

Mistral OCR 3: Estrazione dati e Vision API

L'evoluzione dei sistemi OCR (Optical Character Recognition) si sposta verso la comprensione semantica del layout. Nella guida completa a Mistral OCR 3 analizzo come il modello integri una nuova Vision API 3.0. Questa funzionalità permette di processare documenti complessi non solo riconoscendo i caratteri, ma interpretando la struttura visiva (tabelle, grafici, note a margine) per restituire un output strutturato pronto per l'uso in pipeline RAG o database relazionali.

Pixio: Supervisione a livello di pixel

La computer vision tradizionale spesso si affida a etichette di alto livello o bounding box. Pixio (In Pursuit of Pixel Supervision) propone un cambio di paradigma verso la "Pixel Supervision", riprendendo vecchi studi del 2021 come MAE. Questo approccio addestra il modello a comprendere le relazioni tra i singoli pixel, migliorando la granularità della segmentazione e la comprensione dei dettagli fini, un aspetto critico per applicazioni di imaging medico o analisi satellitare.

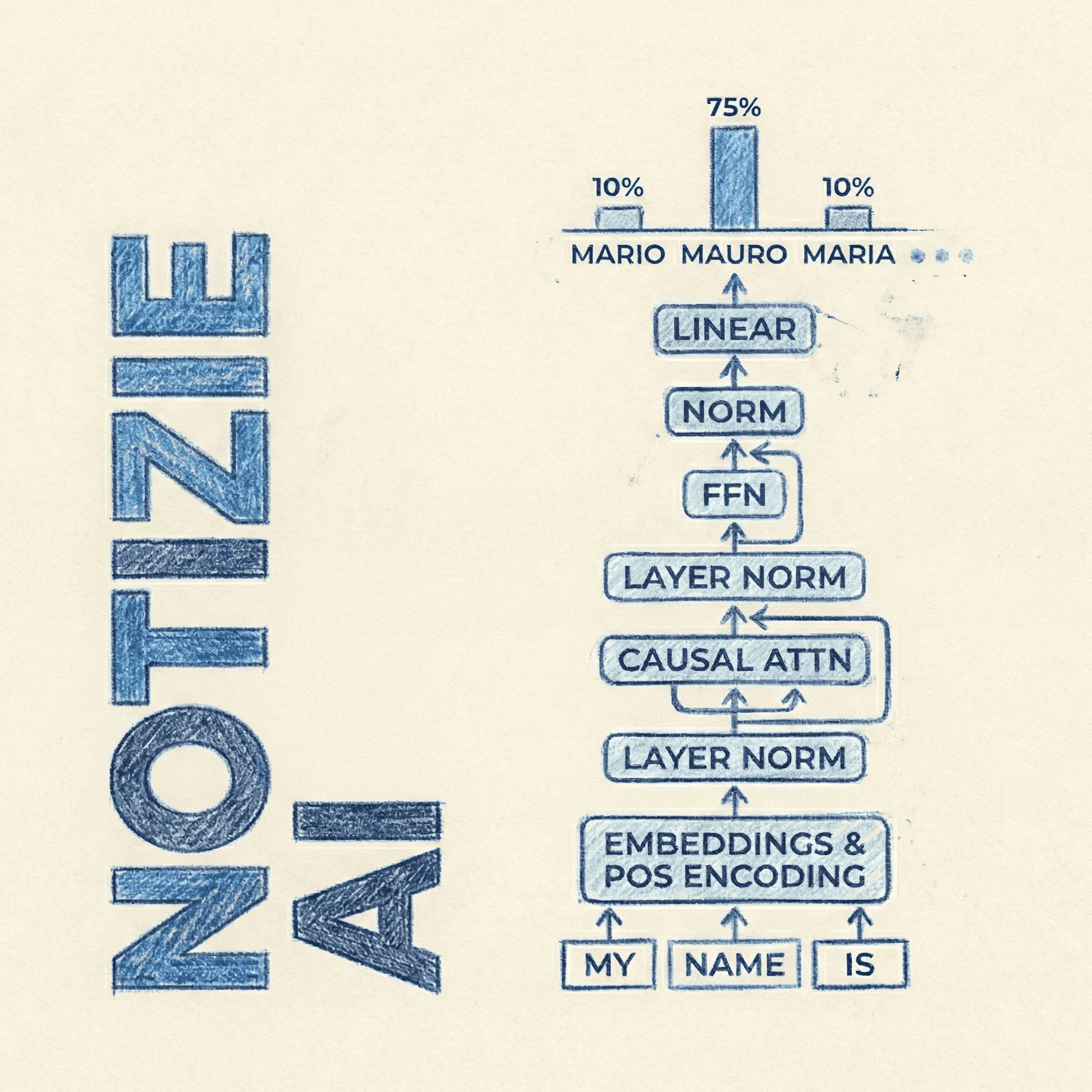

Next-Embedding Prediction (NEPA)

Il paradigma standard dei LLM è la predizione del token successivo (Next-Token Prediction). La guida su NEPA illustra un metodo alternativo: la predizione del prossimo embedding. Spostando il target della predizione dallo spazio discreto dei token a quello continuo delle rappresentazioni latenti, NEPA mira a migliorare l'efficienza computazionale e la qualità semantica della generazione, riducendo potenzialmente i costi di inferenza.

JustRL: Scalare modelli con RL semplificato

L'addestramento tramite Reinforcement Learning (RL) è notoriamente instabile e costoso. Nella guida completa a JustRL esamino una "ricetta" semplificata per scalare modelli da 1.5B di parametri. Il metodo dimostra che è possibile ottenere i benefici dell'allineamento e del reasoning tipici dei modelli più grandi ottimizzando la pipeline di RL, rendendola accessibile anche con risorse di calcolo contenute.

Sigma-MoE-Tiny: Efficienza con 500M parametri

Il trend degli SLM (Small Language Models) continua con Sigma-MoE-Tiny. Questo modello utilizza un'architettura Mixture-of-Experts (MoE) con soli 500 milioni di parametri attivi. L'analisi tecnica evidenzia come l'attivazione sparsa degli esperti permetta di mantenere performance competitive su task specifici, offrendo un rapporto prestazioni/consumi ideale per l'edge computing e i dispositivi mobili.

T5Gemma 2: Comprensione multimodale a lungo raggio

L'integrazione tra visione e testo richiede modelli capaci di mantenere la coerenza su lunghe sequenze. T5Gemma 2 affronta questo problema combinando le capacità di encoding visuale con un backbone testuale robusto. Il risultato è un sistema capace di "leggere" e interpretare contenuti visivi all'interno di contesti estesi, superando le limitazioni di memoria tipiche delle architetture odierne.

Bolmo: Byte-Level Language Model

La tokenizzazione è spesso una fonte di bias e inefficienza nei modelli multilingua. Bolmo elimina questo passaggio intermedio operando direttamente a livello di byte. Questa architettura vocabulary-free permette al modello di gestire qualsiasi stringa di input senza le limitazioni di un vocabolario predefinito, migliorando la robustezza su codice, lingue rare e dati corrotti.

QwenLong-L1.5: Post-training per Long-Context

Gestire contesti da 128k o 1M token richiede più di una semplice estensione della finestra di attenzione. QwenLong-L1.5 introduce tecniche di post-training specifiche per il memory management. Il modello viene raffinato per recuperare informazioni (needle-in-a-haystack) con maggiore precisione, riducendo le allucinazioni quando si opera su grandi volumi di dati testuali.

Error-Free Linear Attention (EFLA)

Se la complessità computazionale dell'attention scala in maniera quadratica con la lunghezza della sequenza, le implementazioni lineari spesso sacrificano la precisione. Error-Free Linear Attention presenta una soluzione matematica per ottenere complessità lineare senza degradare la qualità del segnale. L'articolo approfondisce come EFLA mantenga l'esattezza dell'attenzione softmax standard pur riducendo drasticamente il costo computazionale.

Universal Weight Subspace Hypothesis

Concludiamo con una teoria fondamentale per il futuro del fine-tuning. La Universal Weight Subspace Hypothesis suggerisce che i pesi delle reti neurali, dopo il training, risiedano in sottospazi geometrici comuni. Comprendere questa struttura "universale" apre nuove possibilità per il model merging (fusione di modelli diversi senza ri-addestramento) e tecniche di compressione più aggressive. Studio effettuato con centinaia di esperimenti.