MAGIC: Ottimizzare il Model Merging tramite la Calibrazione della Magnitude

MAGIC ottimizza il model merging calibrando la magnitude di pesi e feature, training-free

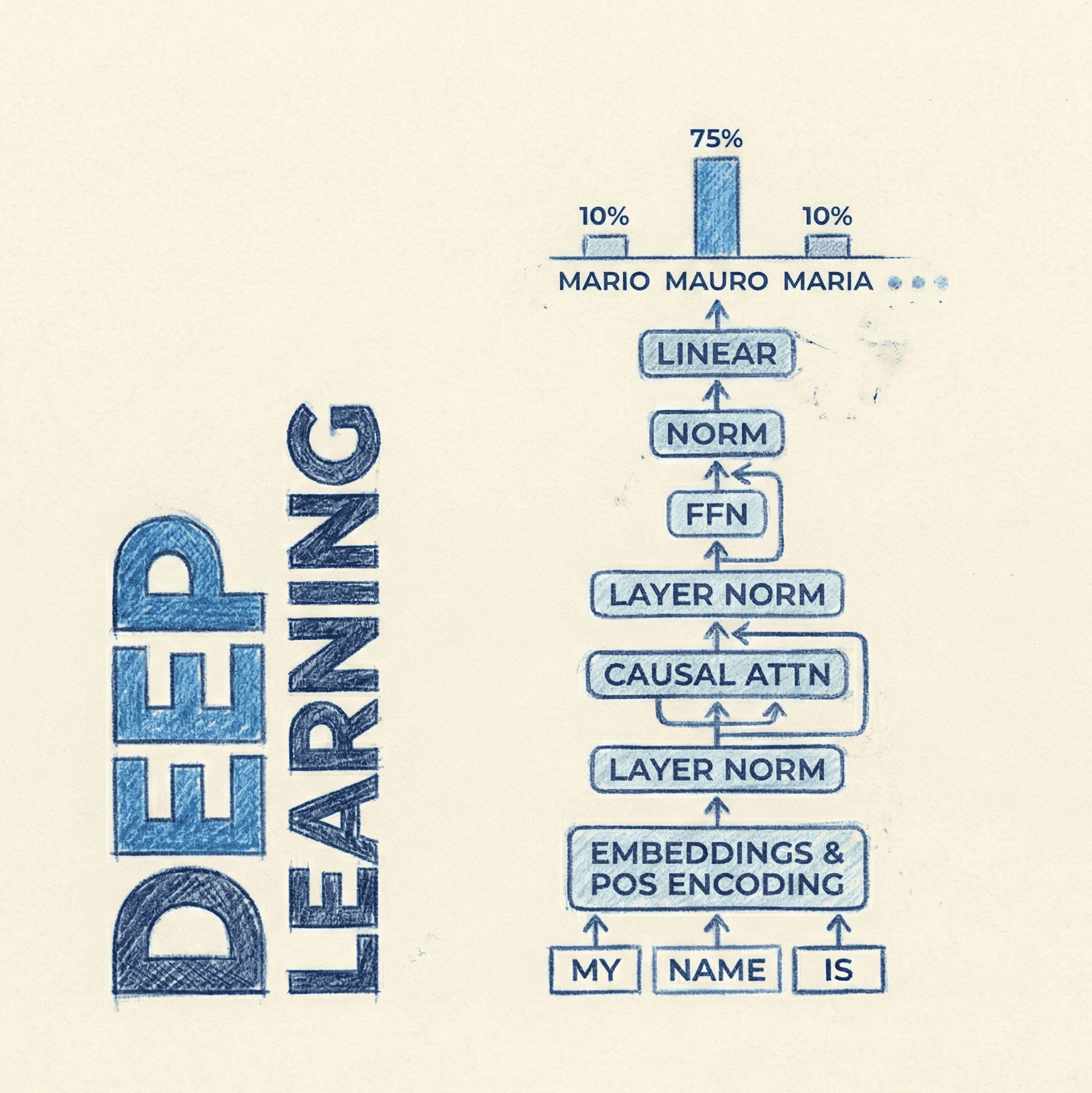

In MAGIC: Achieving Superior Model Merging via Magnitude Calibration (arxiv:2512.19320) viene presentato un framework plug-and-play per migliorare l'unione di modelli specializzati. Il cuore della ricerca identifica che i metodi attuali (come TIES o DARE) si concentrano sull'allineamento della direzione dei vettori dei pesi, ignorando la loro magnitude (magnitudo). Questa discrepanza causa una deviazione delle feature nel modello unito rispetto ai modelli originali, portando a cali di performance. MAGIC introduce tre varianti di calibrazione (FSC, WSC e DSC) per correggere queste scale, ottenendo miglioramenti fino all'8% su modelli Llama e compiti di Computer Vision senza alcuno step di fine-tuning.

- Code: https://github.com/lyymuwu/MAGIC

- Paper: https://arxiv.org/abs/2512.19320

- Dataset: ImageNet-1K, GLUE, MMLU, GSM8K

MAGIC: Obiettivi di ricerca

- Perché i modelli ottenuti tramite merging spesso performano peggio dei singoli esperti? La causa principale identificata è la Magnitude Deviation. Quando i task vector di diversi modelli vengono mediati o filtrati, la magnitudo delle feature risultanti nel modello unito diverge significativamente da quella dei modelli originali, "confondendo" i layer successivi.

- È possibile correggere il merging senza utilizzare dati di calibrazione? Sì, attraverso la variante Weight Space Calibration (WSC). Questa tecnica agisce direttamente sui parametri del modello (weight space) basandosi sulla correlazione lineare tra magnitudo dei pesi e magnitudo delle feature, permettendo un miglioramento immediato data-free.

- Come gestire i layer che reagiscono negativamente alla riscalatura? Il paper introduce il concetto di Magnitude-Sensitive Layers. MAGIC utilizza dei vincoli (constraints) durante la calibrazione per identificare ed escludere o mitigare l'intervento su quei layer dove una variazione di scala drastica degraderebbe ulteriormente l'accuratezza.

MAGIC: Cosa ne pensa Mauro?

- Novità: 3/5. La letteratura precedente (TIES, DARE) si è focalizzata quasi esclusivamente sulla risoluzione dei conflitti di segno (direction), MAGIC dimostra come la semplice calibrazione della scala dei pesi sia un fattore determinante per preservare le capacità dei modelli esperti. Il concetto di calibrazione non è nuovo, MAGIC però è il primo che lo sfrutta in maniera più rigorosa, i.e. non con una semplice threshold globale, capisce che le dinamiche interne del modello cambiano da layer a layer.

- Chiarezza: 4/5. Il paper segue una struttura logica chiara, passando dall'analisi teorica della "magnitude mismatch" alla validazione empirica su architetture diverse (Vision Transformers e LLM). Ogni variante ha un suo box con pseudo codice. La teoria, per chi è interessato è presente nel capitolo 2, Methodology.

- Riproducibilità: 4/5. Il codice è stato rilasciato pubblicamente su GitHub e il metodo non richiede complessi setup di addestramento, rendendo i risultati facilmente verificabili. Documentazione chiara su come fare setup. Iniziamo ad usare

uv, forza! - Test/Ablazioni: 3/5. Su questo avrei voluto vedere qualcosa in più! Cosa succede alla sparsity del modello risultante? Cosa succede se si utilizzano dati out of distribution?

- Accessibilità: 4/5. Essendo una tecnica training-free applicata post-merging, può essere eseguita su hardware consumer (anche una singola GPU di fascia media) in pochi minuti. Non richiede dataset privati. Per la variante FSC richiede solo una piccola quantità di dati non annotati.

MAGIC: Metodi e Tecniche

MAGIC opera attraverso tre moduli principali che intervengono su diversi livelli dell'architettura del modello.

Feature Space Calibration (FSC)

Questa tecnica richiede un piccolo set di dati (unlabelled) per misurare la magnitudo media delle attivazioni. L'obiettivo è calcolare un fattore di scala tale che le feature del modello unito corrispondano alla magnitudo attesa dei modelli specializzati.

Il fattore di scala è definito come:

Weight Space Calibration (WSC)

Per scenari dove non sono disponibili dati, MAGIC agisce sui "task vectors" (). WSC riscala il task vector unito affinché la sua norma rifletta la distribuzione dei modelli originali, evitando che l'operazione di merging (spesso una media) riduca eccessivamente l'intensità dei pesi.

Pseudo-codice dell'algoritmo WSC

Ecco una rappresentazione logica di come MAGIC calibra i pesi in modalità data-free:

import torch

def magic_wsc_merge(base_model, expert_models, lambda_param=0.5):

# base_model: parametri del modello pre-trained

# expert_models: lista di modelli fine-tuned

merged_task_vector = {}

for layer_name in base_model.state_dict():

# Calcolo dei task vectors individuali

tvs = [(m.state_dict()[layer_name] - base_model.state_dict()[layer_name])

for m in expert_models]

# Semplice media (o TIES/DARE) come punto di partenza

avg_tv = torch.stack(tvs).mean(dim=0)

# Calibrazione della magnitudo

mag_specialized = torch.stack([torch.norm(t) for t in tvs]).mean()

mag_merged = torch.norm(avg_tv)

# Fattore di calibrazione

gamma = mag_specialized / (mag_merged + 1e-6)

# Applicazione del fattore al task vector

merged_task_vector[layer_name] = avg_tv * gamma

return merged_task_vector

MAGIC: Dataset

La ricerca utilizza benchmark standard per validare l'efficacia su diverse modalità:

- Computer Vision: Otto dataset tra cui ImageNet-1K, CIFAR-100 e Oxford Pets, utilizzati per testare il merging di Vision Transformers (ViT).

- NLP: Modelli della famiglia Llama-2 e Llama-3 valutati su MMLU (conoscenza generale), GSM8K (ragionamento matematico) e HumanEval (coding).

I dataset sono tutti di pubblico dominio e accessibili tramite HuggingFace.

MAGIC: Licenze

Il codice associato a MAGIC è rilasciato sotto licenza Apache 2.0, garantendo ampia libertà per l'uso commerciale e la modifica. I pesi dei modelli utilizzati (Llama, ViT) seguono le rispettive licenze dei produttori (Meta Community License per Llama).