LIVR: come i token latenti potenziano il ragionamento visivo negli LMM

Migliora il ragionamento visivo dei Large Multimodal Models tramite token latenti e bottleneck visivi, eliminando la necessità di supervisione esplicita.

In Latent Implicit Visual Reasoning (arxiv:2512.21218) viene presentato LIVR, un framework task-agnostic progettato per potenziare le capacità di astrazione visiva dei modelli multimodali. A differenza degli approcci tradizionali che richiedono annotazioni costose o "helper images", LIVR introduce dei latent tokens addestrati a catturare informazioni visive rilevanti attraverso un meccanismo di visual bottlenecking. Questo sistema costringe il modello a far transitare tutte le informazioni necessarie per la risposta attraverso questi token, permettendo la scoperta autonoma di ragionamenti visivi complessi senza supervisione esterna.

- Code: /

- Paper: https://arxiv.org/abs/2512.21218

- Dataset: BLINK Benchmark

LIVR: Obiettivi di ricerca

- È possibile per un LMM apprendere astrazioni visive complesse senza supervisione esplicita? Sì, LIVR dimostra che l'introduzione di token latenti dedicati, accoppiata a custom masking nel calcolo dell'attenzione, permette al modello di scoprire autonomamente come rappresentare internamente le caratteristiche visive necessarie al compito.

- In che modo il visual bottlenecking previene il "leakage" informativo? Modificando la matrice di attention, il sistema impedisce ai token della risposta di accedere direttamente all'immagine originale, forzandoli a utilizzare esclusivamente le informazioni filtrate e processate dai latent tokens.

- LIVR è più efficace del semplice fine-tuning diretto? Sì, i test su nove task ad alta densità percettiva mostrano miglioramenti medi compresi tra il 3.43% e il 6.24% rispetto al Supervised Fine-Tuning (SFT) tradizionale, grazie a una migliore capacità di astrazione.

LIVR: Cosa ne pensa Mauro?

- Novità: 2.5/5. Seppur altri paper hanno provato ad usare latents continui (ILVR, Mirage, LVR), l'approccio è originale poichè semplicemente forza la rete a non "dare conto" ai token originali dell'immagine, ma solo alle controparti latenti.

- Chiarezza: 4/5. Il paper è scritto in modo rigoroso e la suddivisione in due fasi di addestramento rende il processo logico facile da seguire per chi ha familiarità con le architetture transformer.

- Riproducibilità: 4/5. Gli autori utilizzano backbone pubblici come Qwen3-VL e LLaVA-OneVision. Sebbene il codice non sia ancora disponibile nel momento della stesura, la descrizione dei meccanismi di masking e degli iperparametri è sufficientemente dettagliata.

- Costi: 4/5. La tecnica utilizza LoRA per il fine-tuning della componente language, mantenendo congelati il vision encoder e il projector. Questo rende il metodo riproducibile anche per ricercatori indipendenti con un setup mono GPU per i modelli da 3B o 4B parametri.

LIVR: Metodi e Tecniche

LIVR si basa sull'integrazione di componenti strutturali e una strategia di addestramento a due fasi che massimizza l'efficacia dei token latenti.

Latent Tokens e Inizializzazione

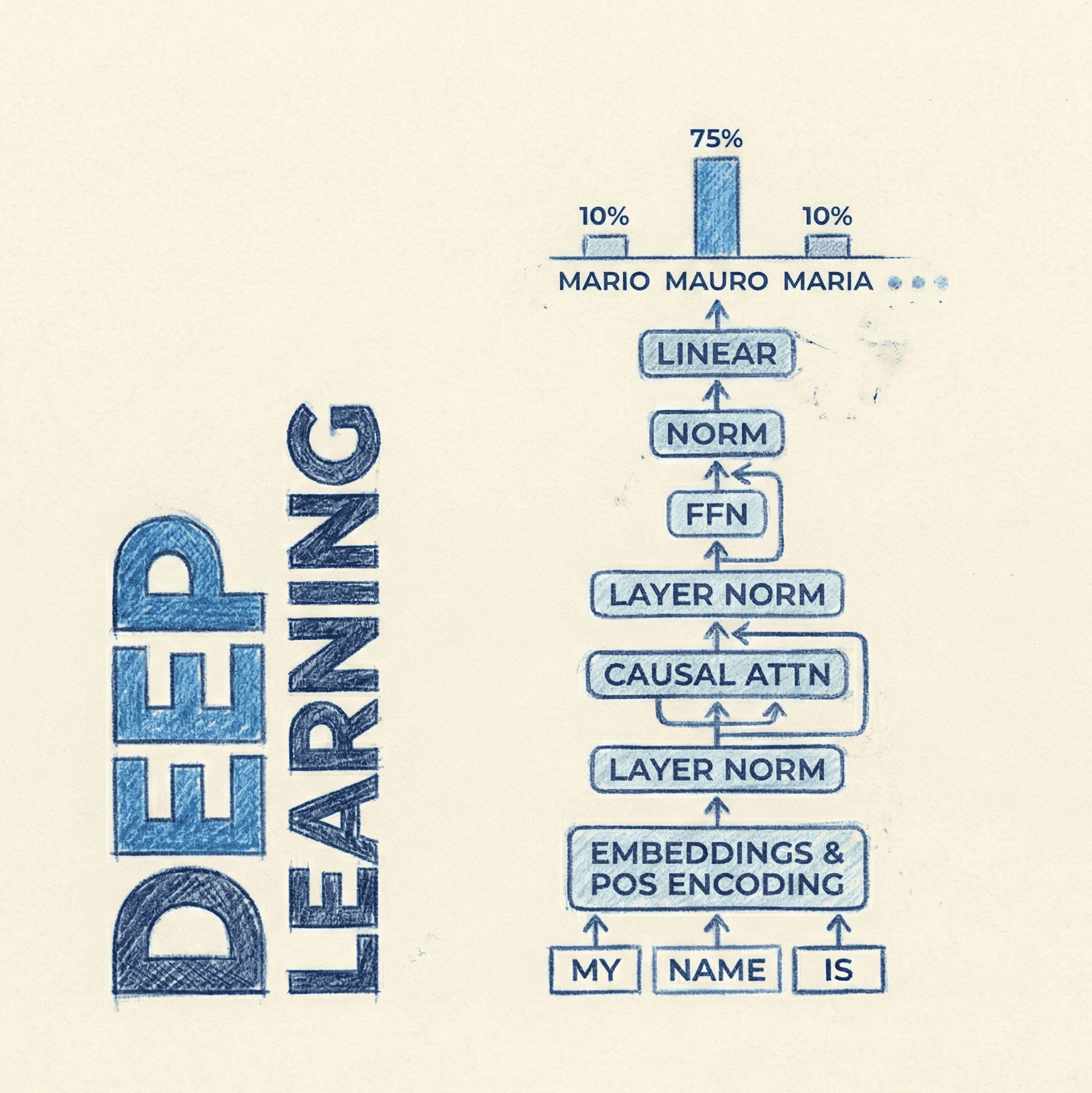

Il modello viene equipaggiato con nuovi token speciali, indicati come , aggiunti al vocabolario esistente . Questi token sono inizializzati casualmente e le loro righe nella embedding table rimangono "unfrozen" durante l'addestramento. A differenza dei token di testo, l'LMM non deve imparare a generarli in output, ma solo a utilizzarli come spazio di calcolo intermedio.

Visual Bottlenecking e Meccanismo di Attention

Il cuore della tecnica è la modifica della maschera di attention per creare un "collo di bottiglia". Durante la prima fase di addestramento, i token della risposta non possono vedere i token dell'immagine .

Pseudo-codice logico per la maschera di attention:

def livr_attention_mask(q_tokens, l_tokens, i_tokens, a_tokens):

# Masking logic for Stage 1

mask = torch.ones(total_len, total_len)

# Answer tokens 'a' cannot see Image tokens 'i'

mask[a_indices, i_indices] = 0

# Prompt tokens 'q' cannot see Image tokens 'i'

mask[q_indices, i_indices] = 0

# Latent tokens 'l' CAN see Image tokens 'i' and Prompt 'q'

mask[l_indices, i_indices] = 1

mask[l_indices, q_indices] = 1

return mask

Stage-wise Training

L'addestramento avviene in due momenti distinti per stabilizzare l'apprendimento delle rappresentazioni latenti.

Stage 1 (Bottleneck training): Si ottimizza la perdita di verosimiglianza (Negative Log-Likelihood) solo sui token della risposta, mantenendo il bottleneck attivo:

Stage 2 (Refinement): Si ripristina la maschera di attention standard, permettendo al modello di utilizzare sia i token dell'immagine originale che le rappresentazioni arricchite nei token latenti.

LIVR: Dataset

Il lavoro utilizza una selezione di 9 task provenienti dal benchmark BLINK, specificamente scelti per la loro natura "perception-heavy":

- Counting (conteggio oggetti)

- Jigsaw (ricomposizione immagini)

- Object Localization (localizzazione)

- Visual/Semantic Correspondence (corrispondenze visive e semantiche)

- Art Style Classification

- Functional Correspondence

- Relative Reflectance

- Visual Similarity

Questi dataset sono ideali perché richiedono una comprensione spaziale e di dettaglio che i modelli puramente testo-centrici faticano a gestire.

LIVR: Licenze

Il paper e i materiali correlati sono rilasciati sotto licenza CC BY 4.0, che permette la condivisione e l'adattamento del lavoro citando opportunamente la fonte.