4D-RGPT: Migliorare la comprensione 4D nei Multimodal LLM

4D-RGPT integra la comprensione 4D a livello di regione nei Multimodal LLM tramite Perceptual Distillation, definendo nuovi standard su R4D-Bench.

Il paper 4D-RGPT (arxiv:2512.17012) pubblicato da NVIDIA affronta i limiti dei modelli multimodali attuali (MLLM) nella percezione dello spazio 4D (3D + tempo). Sebbene i modelli esistenti eccellano nel vision-language, faticano a comprendere la profondità e la dinamica temporale. 4D-RGPT introduce un framework di Perceptual 4D Distillation (P4D) che trasferisce la conoscenza da un modello esperto 4D "frozen" a un LLM student senza aggiungere costi computazionali in fase di inferenza.

L'architettura utilizza un encoder regionale dedicato e un sistema di encoding temporale migliorato per rispondere a domande complesse su oggetti in movimento. Il lavoro introduce anche R4D-Bench, un benchmark specifico per il ragionamento 4D a livello di regione, colmando il gap tra la percezione visiva 2D e la comprensione geometrica tridimensionale nel tempo.

- Code: /

- Paper: https://arxiv.org/pdf/2512.17012

- Project Page: https://ca-joe-yang.github.io/resource/projects/4D_RGPT

- HuggingFace: https://huggingface.co/papers/2512.17012

4D-RGPT Domande di ricerca

- Come integrare la percezione 4D a grana fine nei MLLM senza introdurre overhead in fase di inferenza? Il paper propone la Perceptual 4D Distillation (P4D). Questa tecnica permette di addestrare lo student MLLM a imitare le rappresentazioni di un encoder esperto 4D. Poiché i moduli di distillazione sono utilizzati solo durante il training e rimossi in fase di produzione, il modello mantiene la velocità di un LLM standard pur possedendo capacità percettive avanzate.

- In che modo è possibile migliorare la consapevolezza temporale dei token visivi per task di tracking e profondità? Gli autori introducono il Timestamp Positional Encoding (TPE). A differenza dei positional encodings standard, il TPE inietta segnali temporali espliciti direttamente nelle feature estratte dall'encoder regionale. Questo permette al transformer di distinguere la progressione cronologica degli oggetti all'interno di una sequenza video complessa.

- Quali sono le lacune dei benchmark attuali nella valutazione del ragionamento 4D? I benchmark esistenti si concentrano spesso su scene statiche o descrizioni globali del video. Il paper dimostra che questi non misurano la capacità di "grounding" spaziale. Per questo viene creato R4D-Bench, che richiede al modello di identificare regioni specifiche e rispondere a domande sulla loro evoluzione geometrica e interazione nel tempo.

4D-RGPT Metodi e Tecniche

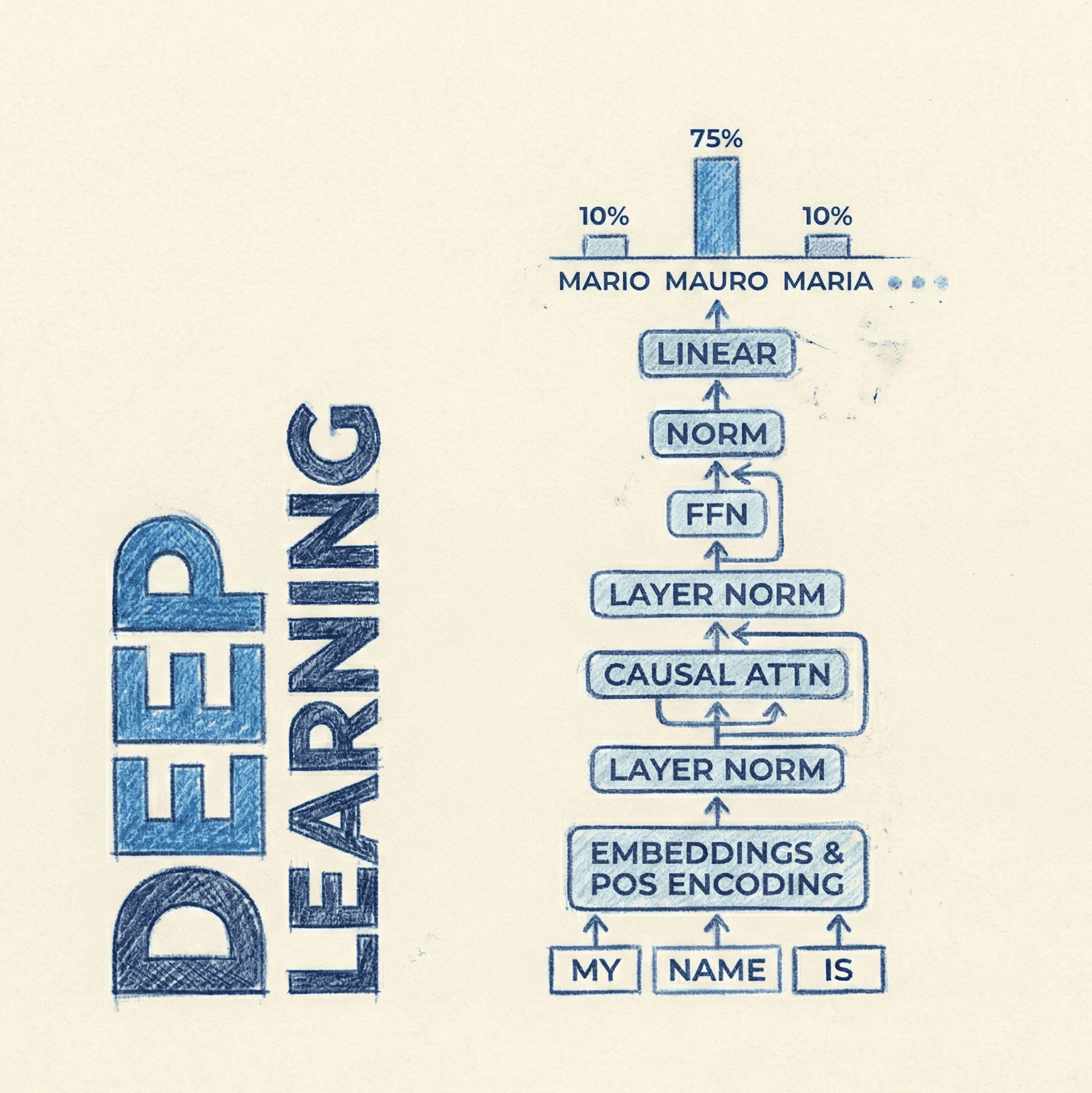

L'architettura di 4D-RGPT si basa su tre pilastri fondamentali che permettono la transizione da una comprensione puramente visiva a una percezione spaziale dinamica.

Perceptual 4D Distillation (P4D)

La tecnica core è la distillazione della percezione 4D. Viene utilizzato un modello insegnante (teacher) specializzato in point cloud o video 4D. Il processo di ottimizzazione minimizza la discrepanza tra le feature dello student e quelle del teacher attraverso una loss combinata:

La componente agisce nello spazio delle feature latenti, calcolando la distanza tra le mappe di attivazione dell'encoder dello student e del teacher:

4D Regional Encoder e TPE

Per gestire il "region-level understanding", il modello utilizza un 4D Regional Encoder. Questo modulo estrae token specifici per le aree di interesse segnate tramite bounding box. Il Timestamp Positional Encoding (TPE) viene aggiunto per preservare l'ordine temporale dei frame:

import torch

import torch.nn as nn

class TimestampPositionalEncoding(nn.Module):

def __init__(self, d_model, max_len=500):

super().__init__()

self.encoding = nn.Parameter(torch.zeros(max_len, d_model))

def forward(self, regional_features, timestamps):

# regional_features: [batch, frames, regions, dim]

# timestamps: indici temporali dei frame

t_embed = self.encoding[timestamps, :]

return regional_features + t_embed.unsqueeze(2)

Explicit Distillation Task

Oltre alla loss latente, il modello viene addestrato su task espliciti di ricostruzione 4D, come la predizione del flusso ottico (optical flow) o della profondità relativa. Questo forza lo student a catturare segnali geometrici reali piuttosto che limitarsi a correlazioni testuali.

4D-RGPT Dataset

Il contributo principale a livello di dati è R4D-Bench. Si tratta di un benchmark per la Region-level 4D Video Question Answering, costruito con una pipeline ibrida automatizzata e verificata da esseri umani. Include scene dinamiche con variazioni di profondità e interazioni tra oggetti.

Per l'addestramento, 4D-RGPT utilizza anche dataset 3D/4D esistenti come ScanNet e Waymo Open Dataset, riconvertiti per task di istruzione multimodale.

4D-RGPT Licenze

Il dataset R4D-Bench e il codice di 4D-RGPT non hanno una licenza esplicitamente dichiarata nel pre-print.